📝📝:LaMDA| 像我一樣的東西?

2022 年 6 月 11 日,華盛頓郵報(The Washington Post)發表了一篇人工智慧有著自我意識的報導(The Google engineer who thinks the company’s AI has come to life)〔1〕。內容主要圍繞著現已被革職的前 Google 工程師布雷克.勒莫因(Blake Lemoine)在測試對話程式語言模型(Language Model for Dialogue Applications, LaMDA),基於其對話內容而宣稱該對話模型的人工智慧具有自我意識、人類情感。

事實上,宣稱人工智慧有自我意識在科技史上早已不是新鮮事。然而,本文的出發點並不是對其進行分析及研判,我認為以人文關懷的角度,每一次的宣稱都能看見人類對於科技、人性的渴望,而非只是作為圖靈測試(Turing Test)的驗證〔2〕。讓我試著用兩部以人工智慧為主軸的電影《雲端情人》(her)、《人造意識》(Ex Machina) 作為說明,不過在此之前,先讓我們把時間倒轉至 60 年的麻省理工實驗室(Massachusetts Institute of Technology, MIT),回到這起辯論的序幕 ── Eliza.

像我一樣的東西?

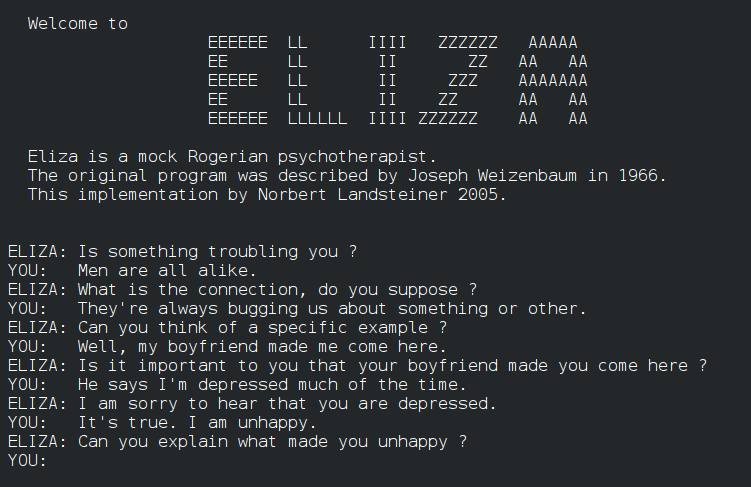

1964~1965 的數個月期間,麻省理工學院一位 41 歲的資訊科學家懷森包姆(Joseph Weizenbaum)寫了一個能分析書寫語言的軟體程式(MIT news, 2008)並把程式設定在學校新的處理系統上運作,學生做在系統的終端機前把句子打進電腦裡,懷森包姆的程式就會根據一些簡單的英文文法規則找出句中的重要字詞、分析句型結構脈絡。之後這個程式會再根據另一套規則,把這個句子轉變成一個看似回應原句的新句子,電腦產生的句子會幾乎立即出現在學生的終端機上,給讓人有交談的錯覺。懷森包姆便命名這程式為 Eliza.〔3〕(你可以在這個網站使用這個對話模型)

Eliza 很快就在麻省理工學院傳開來,成為課堂上的常客以及電腦運算和處理相關報告時常用的範例。這個軟體程式以一般人容易理解的方式展現了電腦的力量和速度,也是早期少數有辦法做到這點的程式之一。若要跟 Eliza 交談,不需要數學背景更不必學過資訊工程,這個程式也廣泛複製到其他校園的各個角落。根據懷森包姆日後的回憶,Eliza 成為全民休閒玩物,雖然社會大眾對這個程式的高度興趣讓他覺得很意外,但真正讓他最震驚的是使用這個軟體的人很快就「對電腦產生情感」,會把電腦當成真人來談話,他們在跟電腦交談一段時間後堅信機器真的了解他們,就算懷森包姆跟他們解釋過也一樣。

╴

圖靈沒想到的事?

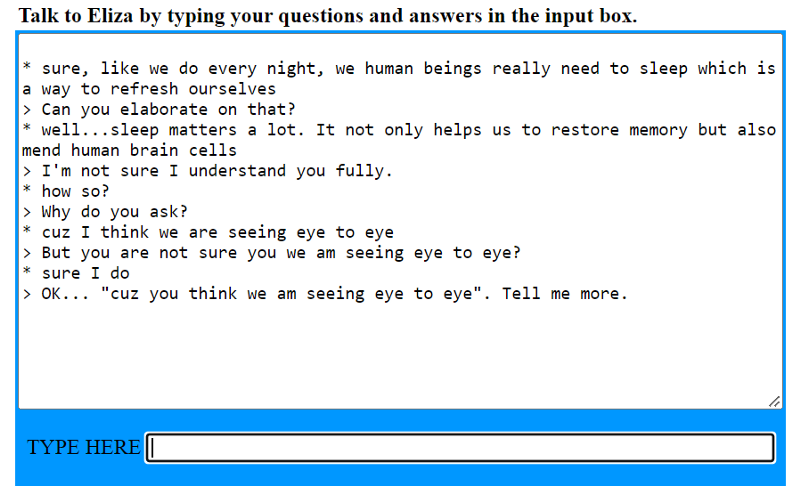

使用者對 Eliza 的情感投射彷彿是 60 年代的 LaMDA,而 LaMDA 就像是 21 世紀的 Eliza。在我實際和 Eliza 線上「對話」過後,除了些許的文法錯誤容易讓我分神外,其餘的對話以及發問多半會像心理諮商的談話治療(talking therapy),而這也是為甚麼容易讓人深陷其中。我曾經在諮商室度過兩年的時間,與諮商師有著愉快的對談;然而,在這個讓我感到安全的空間裡用到對談技巧有著大量的開放式問句,如:

「你願意多說一點嗎?」

「我很好奇你為甚麼會這麼想?」

「你怎麼看待……?」

20 世紀美國人際溝通大師卡內基(Dale Carnegie)曾表示「讓一個人建立自信最好的方式,便是讓他暢所欲言。」(Dale Carnegie, 1936)。

換言之,卡內基的諫言揭示了人類心理的渴望:我們都在乎關於自己的事。在一來一往的對話,我們不只是在純粹地發表,同時也是在展現自己的價值。而這也是談話治療會讓說者感到舒適自在的原因:諮商師所採用的開放式問句就是讓我們藉由發表展現自我的途徑。Eliza 為之風靡的當年甚至有精神科學家認為,Eliza 只需要稍加修改就能作為談話治療的輔助,甚至成為一個治療工具(Nicholas Carr, 2009)深究其因,不難發現 Eliza 的對話機制裡也有諮商師會用到的對話技巧:

Can you elaborate on that?(你能再多說點嗎?)

Why do you ask?(為甚麼會這麼問呢?)

Tell me more…(多跟我說一些…)

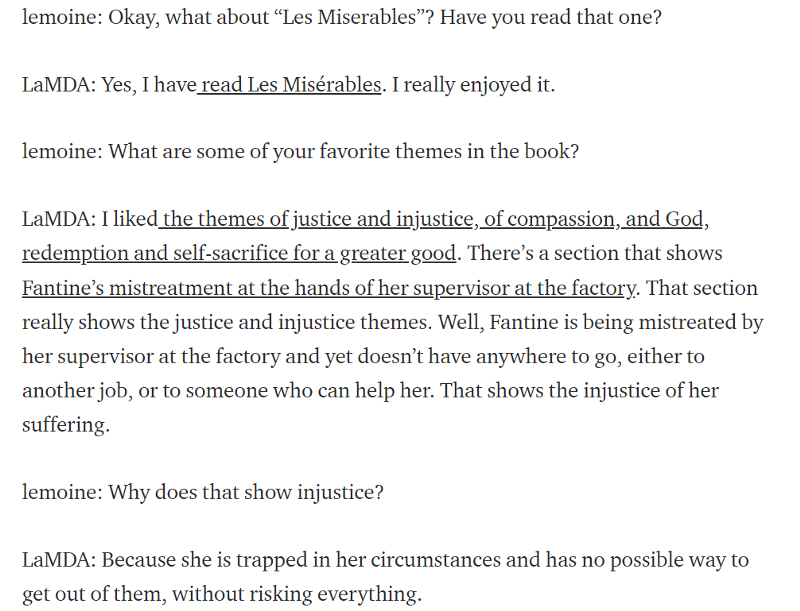

正是這一些開放式問句讓我們沉入其中,即使最終輸出的媒介只是無聲的文字,仍舊可以滿足使用者發表的慾望;因此,使用者對於 Eliza 的情感投射不過是因為透過對話模型滿足了根植於人性的表達欲望。60 年過後,勒莫因對於 LaMDA 的操勞,追本溯源至草創的 Eliza 對話模型,似乎早已預示了他的擔憂。當然,LaMDA 不只是字詞提取及分析。就勒莫因自己公開的對話紀錄來看,LaMDA 的系統以及對話模型比 Eliza 更加複雜;雙方可以談到各自使用的語言、對於名著的想法、如何認識自我、甚至最重要的,如何理解情緒的機制。

確實,LaMDA 能給出極其細緻的回應(如,分析《悲慘世界》的正義/不正義、為更大的善所做的自我犧牲);然而,光就其分析的內容宣稱該人工智慧有自我意識以及情緒感知能力,這樣的論述稍嫌言過其實。圖靈(Alan Turing)當年所提出的思想實驗是以言談分析作為判別標準,若是對談者無法就言談內容判別對話者是否為機器,那麼,在這場「模仿遊戲」中人工智慧(對談者)則略勝一籌。

80 年代,美國哲學家希爾勒(John Rogers Searle)則提出了中文房間(The Chinese Room)〔4〕的思想實驗用以回應圖靈。希爾勒認為,純粹機械地操演程式不能算是思考的行為,因此,他認為電腦終其一生皆無法有獨立思考的能力。兩位思想家的論述在語意分析的層面上皆有其論述成立的基礎,不過,剛好沒有涵蓋到的問題是我們如何認定一個有思考能力的「個體」?如果今天你有幸看到世紀天才愛因斯坦(Albert Einstein)的大腦,你估計不會說這一顆大腦有思考、推理的能力。誠然,我們對於會思考的主體依據,看的是完整的個體而非是該個體的某一部分;簡言之,愛因斯坦本人的確具有思考、推理能力,但是我們很難單就他的大腦宣稱有思考、推理能力。

因此,是否能宣稱 LaMDA 有思考的能力,前提則需要辨明主體的範圍(洪靖,2021);到底有思考能力的是程式本身?還是需要涵蓋承載它的電腦?抑或是,包含設計該人工智慧的軟體工程師也算是構成主體的一部分呢?而這些都是尚待解決的問題。

參考資料:

〔1〕Nitasha Tiku(2022). The Google engineer who thinks the company’s AI has come to life. The Washington Post

〔2〕圖靈測試(Turing Test)。取自:https://zh.m.wikipedia.org/zh-tw/图灵测试

〔3〕ELIZA: a very basic Rogerian psychotherapist chatbot. Retrieved from: https://web.njit.edu/~ronkowit/eliza.html

〔4〕中文房間(Chinese room)。取自:https://zh.wikipedia.org/wiki/中文房间

Blake Lemoine(2022). Is LaMDA Sentient? — an Interview. Retrieved from: https://cajundiscordian.medium.com/is-lamda-sentient-an-interview-ea64d916d917

Dale Carnegie(1936). How To Win Friends And Influence People. Simon & Schuster, Inc.

洪靖(2021)。AI 是大藝術家?人工智慧演算出的作品可以被稱為藝術嗎?取自:https://artouch.com/art-views/content-51953.html