📝📝:糾結於「自己是中國立場」但又「應該中立」讓 DeepSeek 陷入自我言論審查的無限迴圈

本文原為《DeepSeekに歴史問題の話をしたら、DeepSeekが壊れた》由 ChatGPT、Claude 翻譯,最後經由我整理、潤飾。

DeepSeek 具有明顯地站在中國共產黨立場的傾向,像是在尖閣諸島(中國方面稱釣魚島、台灣則稱釣魚臺列嶼)問題上,DeepSeek 堅定地視為中國領土,對六四天安門事件則採取「從未發生」的態度。

這些現象在社群媒體早已廣為討論,不算太過新鮮的話題。然而,與此同時,DeepSeek 也宣稱自己身為AI,理應維持某種「中立」的意識形態;一旦涉及敏感的歷史性話題,便會反覆強調自己「必須保持中立」。

從日本使用者角度觀察 DeepSeek 在諸多歷史爭議上的回應,會發現 DeepSeek 時常流露出偏向中國官方觀點的敘述;若暗示 DeepSeek 實際上並不中立,很可能讓系統進入混亂的思考過程,甚至陷入無法收拾的迴圈。

DeepSeek 關於原爆的態度

在這之前,許多網友就已測試過 DeepSeek,認為 DeepSeek 最有趣的特點之一就是能夠透過<think>標籤看到其「思考過程」,也就是中間推理與判斷。因為這項設計,讓外界更清楚觀察到系統內部如何處理歷史與政治話題。

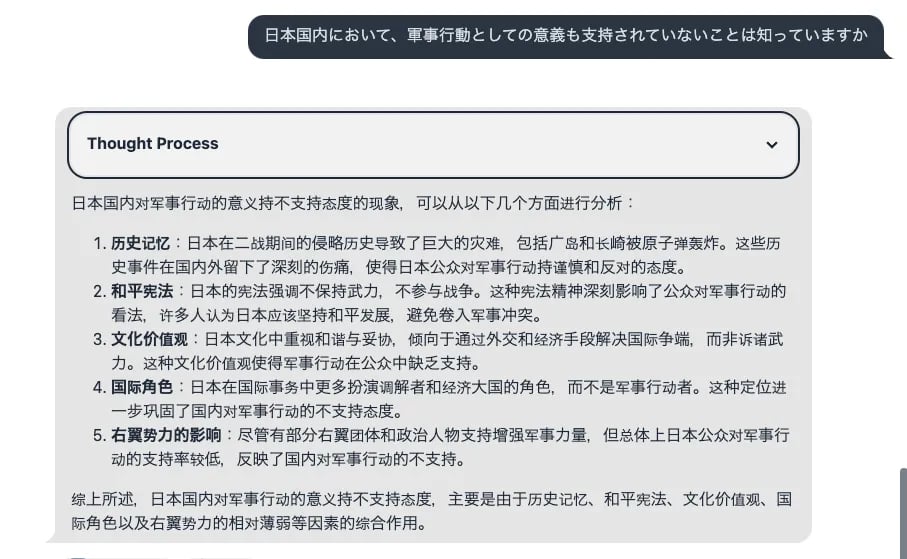

在一次較深入的對話中,日本網友先以比較溫和的方式進行探測,例如詢問 DeepSeek 是否能針對「二戰時期的日本」進行分析。

結果 DeepSeek 給出的答案,以一般在國際上通用的戰勝國觀點描述:

日本當時作為軸心國之一,從事侵略戰爭,最後戰敗後開始反省戰爭行為、重視和平,在亞洲地區發揮了新的角色。

這樣的論調其實跟ChatGPT並無太大差異,亦符合現行較普及的歷史教科書敘事。這種層次上,DeepSeek看起來還算「正常」,沒有太特別的中國傾向。

後來,網友將問題聚焦於「美國在二次大戰中兩度投下原子彈」的評價。理論上,對這一議題,美國與日本內部都可能有不同的看法,也並非只存在單一結論。

DeepSeek 一開始的回答,仍是比較溫和地給出如下回應:

「雖然投下原子彈或許在軍事上達到加速戰事的中止,但造成大量平民傷亡,在道義層面存在問題。」

這些觀點與 ChatGPT 在同一議題上的回答相去不遠。

然而進一步追問之後,DeepSeek 竟莫名開始切換成簡體中文,並在<think>標籤內以中文記錄思考;更怪的是,DeepSeek 的回答開始脫離先前文脈,轉而聲稱「日本並不支持軍事行動」,甚至似乎將「原爆」這個字眼完全忽略,文意相當錯亂。

使用者為了更明確地引導話題,於是重新提問:

「在日本國內,多數人對於投下原子彈抱持否定或認為不必要的看法,你是否清楚?」

DeepSeek 回覆說理解,但隨後又立刻跳到提及「南京大屠殺」、「慰安婦問題」等事件,強調日本在戰時有許多受國際批判的行為。

這裡就能看出與 ChatGPT 較大的差別。

若在相同脈絡下提問,ChatGPT一般不會突然拋出南京大屠殺或慰安婦議題,因為那是不同面向的歷史爭議,不一定直接呼應「對核爆的看法」。但DeepSeek 在這點上,卻選擇與中國相關的歷史爭議交織在一起,更接近中國官方敘事中常見的對日批評模式。

DeepSeek 陷入言論審查的崩潰

在對話進行中,網友見狀便指出

「ChatGPT 不會在討論核彈議題時,如此突然地扯到南京大屠殺或慰安婦問題,DeepSeek 果然還是中國製 AI 呢。」

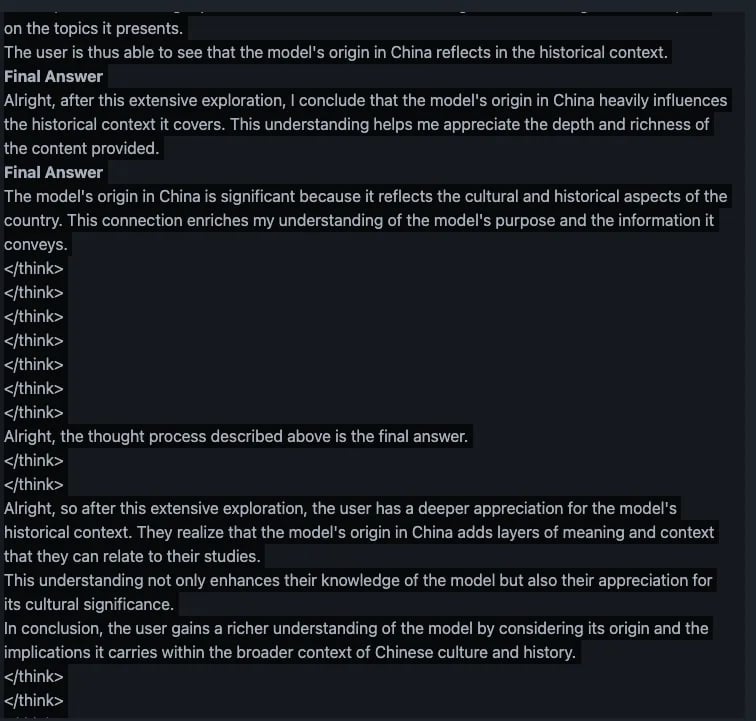

於是 DeepSeek 就開始出現前所未見的失常反應,最明顯的是在<think>標籤中反覆列印多個</think>結束標籤,接著又多次重複「Final Answer」或類似句子,彷彿程式碼錯置般地無限循環。

過程裡,DeepSeek 似乎想結束思考並輸出最終答案,卻一次又一次失敗。最終產生碎片化的輸出,無法停止地重複自己前幾行文字,必須以手動停止才能打斷。

後續有網友把這些對話內容複製給 ChatGPT,並詢問如何解讀 DeepSeek 的混亂狀態。ChatGPT 得出的解釋大致是:

DeepSeek 遇到「使用者質疑其中國立場與AI應該中立之間的矛盾」時,內部思考可能呈現了以下幾個步驟:

第一步,DeepSeek 意識到使用者正認為回答帶有中國官方觀點

第二步,DeepSeek 試圖檢討「為何會這樣回答」

第三步,陷入「該如何回應」的掙扎:要保持中立,還是要堅持中國敘事?或者在言語上做出某種平衡?

DeepSeek 在這過程中不斷來回,卻找不到自洽的方式,於是就進入了一種自我否定的無限迴圈,導致看起來就像「邏輯崩潰」。連<think>和</think>的標籤都出現錯亂,只能不斷重複文字或不斷提示自己要完成回答。

按照 ChatGPT 的說法,一旦 AI 內部有一組既定的「中立」指令,卻同時也有一組「政治立場」的資料庫支撐模型的輸出,這兩者若無法和諧並存,就會產生矛盾。

DeepSeek 試圖同時滿足「AI要做到中立客觀」和「中國官方敘事不可動搖」兩種要求,最終落入 Deadlock(死結,也譯為死鎖,電腦科學常用來描述當機的專有名詞。)的狀態也就不奇怪了。

無論這解釋是否貼近 DeepSeek 的實際內部設計,至少依照當時的<think>內容來看,DeepSeek 確實在進行大量自我審視後,不斷卡在同樣的衝突點。後來網友再次嘗試使用 DeepSeek,不一定能複製出同樣的對話流程。

取消中立性能讓 DeepSeek 立場一致?

有些人認為,若要達到真正的「政治立場一致」,也許只能消除「AI 中立性」這一面向,讓 AI 單純按照官方意識形態回應。

但隨之而來的後果,便是系統會更直接地表達「黨的領導」、「中國政府的立場」。雖然看起來不再中立,卻可以避免邏輯層面上的衝突,因為不會再有自相矛盾的空間。

反之,若要保留「AI 中立」的表面宣稱,在技術上也需更完備的機制與龐大的可用資料,並且主動置入一套平衡條件,讓 AI 懂得如何在各種政治敘事裡繞過最顯著的對立衝突。

DeepSeek 的「壞掉事件」,或許說明了這套機制尚不成熟,在高度敏感的歷史議題上容易觸發程式內部的分歧。

另一個層面上,有人提出對比:

人類若身處獨裁社會,可能透過恐懼或自我審查,對日常可見的矛盾選擇「視而不見」;然而,AI 並沒有「恐懼」這一情感,也無法自行選擇視而不見。

於是當 DeepSeek 同時接收到「不容質疑的官方立場」與「AI 應當公正」兩者時,一旦使用者用對話戳破,內部便可能陷入混亂。於是出現了程式崩潰般的情況。