IBM 谢东:AI 进入生活,我们该怎么信任它?

本文首发于航通社,原创文章未经授权禁止转载。航通社微信:lifeissohappy 微博:@航通社

在 AI 进入人类生活每个角落的时候,人们一定会涌起一个疑问:AI 给我们的这些建议是对的吗?如果一个技术非常强大,但是却不能完全符合人类道德,那么如何评价它的价值?

如果不认真重视、有效解决 AI 的可信性问题,那么 AI 越强大,人们越不敢用。在 2019 世界人工智能大会(WAIC)期间,IBM 副总裁、大中华区首席技术官谢东博士通过主题演讲,阐述了 IBM 主推的“可信 AI”概念。

AI 飞速发展带来可信性问题

在计算机系统投入应用的第一天,计算机系统及算法的可信性问题就伴随出现了。

今年是人类登月 50 周年。遥想当年,我们在设计飞船时采用的计算机,其算力甚至难以同现在的智能手机相提并论。那么,为什么在计算人类从地球飞向月球的轨道时,我们足够相信这个算法呢?这是因为当时的计算有完整的数学理论、物理定理支持。

时至今日,以深度学习为代表的 AI 算法,先天就有一些不可解释性。更不用说,我们通常会模仿人对问题的理解和判断来设计 AI。由于人类对自身都不是很了解,连自己都搞不清楚自己到底是怎么想的,到底为什么做这个判断。

所以,在 AI 进入人类生活每个角落的时候,人们一定会涌起一个疑问:AI 给我们的这些建议是对的吗?

- 当 AI 医生诊断我们得了某种重病,或是提供治疗方案时,我们会担心它预测是否准确。

- 当 AI 分析师做出投资建议时,我们会担心是否可以把血汗钱押在这上面。

- 当 AI 老师制订了一套符合你能力的教学方案时,我们也会担心这是否真的就适合自己。

- 当 AI 算法综合大数据对我们做分析和信息流推荐时,我们更会警惕它是不是“真的懂我”,自己有没有被公正对待。

有些时候,AI 并不能完全符合我们的期待,会让人失望甚至恐惧。

- 当行人违反交通规则,没有走人行横道的时候,有的无人驾驶汽车会判断为不用刹车,全球首例无人驾驶车辆事故由此产生;

- 当医疗 AI 试图给病人开药的时候,如果此前忘记录入并发症信息,开出的药方可能对某些患者是致命的;

- 若是没有专门介入,人脸识别等算法无法准确地识别数据较少的少数族裔面孔,形成严重的偏见;

- 而训练 AI 算法的模型需要大量数据,这些数据也可能未经授权,让普通人的隐私在不知不觉中被“偷走”。

如果一个技术非常强大,但是却不能以符合人类道德的方式服务人类,那么如何评价它的价值?所以,如果不认真重视、有效解决 AI 的可信性问题,那么 AI 越强大,人们越不敢用。

IBM 可信 AI 概念的提出

谢东介绍说,要正确的发展人工智能,就必须提出可信赖的人工智能。人工智能的未来在于信任,如果想要驱动业务成功,人工智能就不能隐藏在“黑盒子”中。

IBM 对 AI 发展有几个基本论点:

- AI 不是代替人类的,而是人类的辅助;

- AI 的数据和洞察(即结论)均属于其创造者,也就是客户;

- AI 必须被人们所信任。

近年来,IBM 坚持不懈的向客户和业界解释,在其产品和服务中的 AI 是何时,何处,以什么方法植入的,其模型是用什么数据来训练的。

在此基础上,IBM 提炼出可信 AI (Trusted AI)的四条原则:

- 公平性(Fairness):AI系统应该采用不带偏见的数据集和模型,从而避免对于特定群体的不公平;

- 可解释性(Explainability):AI系统所提供的决策或建议不是一个不可解释的黑箱,应该能够被用户和开发者所分析、理解;

- 健壮性(Robustness):AI系统应该安全和可靠,不会被篡改,也不会受被“污染”的训练数据集影响;

- 透明性(Transparency):AI系统可以被透明化管理,其开发、部署、维护等可被追踪,能够在生命周期范围内被审核。

IBM 非常重视可信 AI,不仅概述实现这些目标的各种方法论,还推出了各种实用工具,并在自身提供的解决方案设计和实践的初期,就完整考虑了这些可信问题,让客户可以放心使用。

IBM z 系列大型主机、LinuxONE 主机、Power 服务器、存储等企业级专用硬件;数据管理、人工智能、应用管理和操作系统等企业级软件;以及 IBM 研究院的各种创新实践,及多年积累的行业经验,让 IBM 从硬件、软件、服务方面入手,为企业交付可信 AI 的数字基础设施。

IBM 可信 AI 的实际开发和应用

谢东介绍称,IBM 特别注重将对 AI 的信任研究,转化为实际产品和平台,同时强调构成技术团队的人员多样性和包容性。针对 IBM 可信 AI 四原则的每一方面,都有相对应的具体工具和产品投入使用。

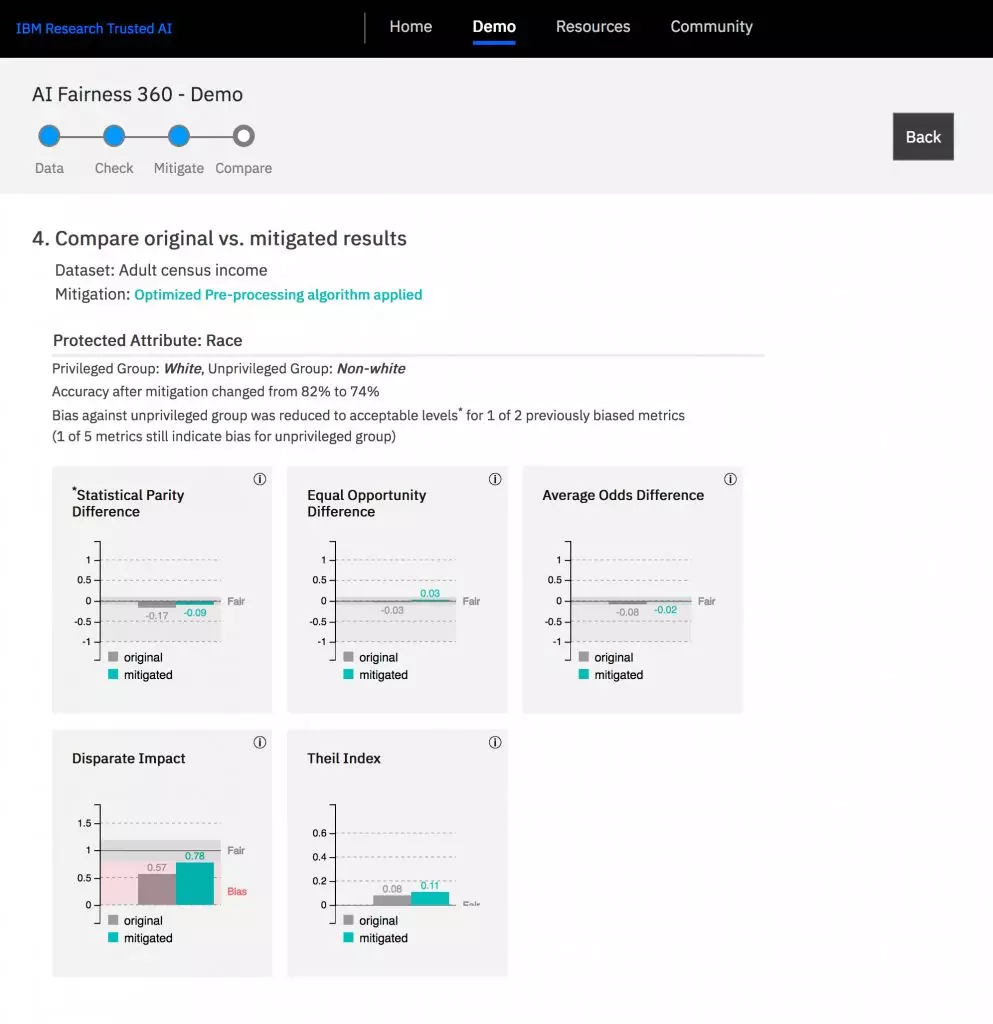

公平性:AI 系统都是通过人提供的数据,人打的标签,或者是人历史上的经验训练出来的。我们不能保证这些基础数据是没有偏见的,但是不希望人造成的偏见就这么带到 AI 系统里。

IBM 提供了开源工具集合 AI fairness 360,包含用于检查和减轻 AI 中不必要偏见的算法。在一个训练好的模型中,它的输入输出之间如果存在某种强相干因素,这些工具就能检查此类强相干是不是开发者所期望的,是不是因为一些偏见造成的。

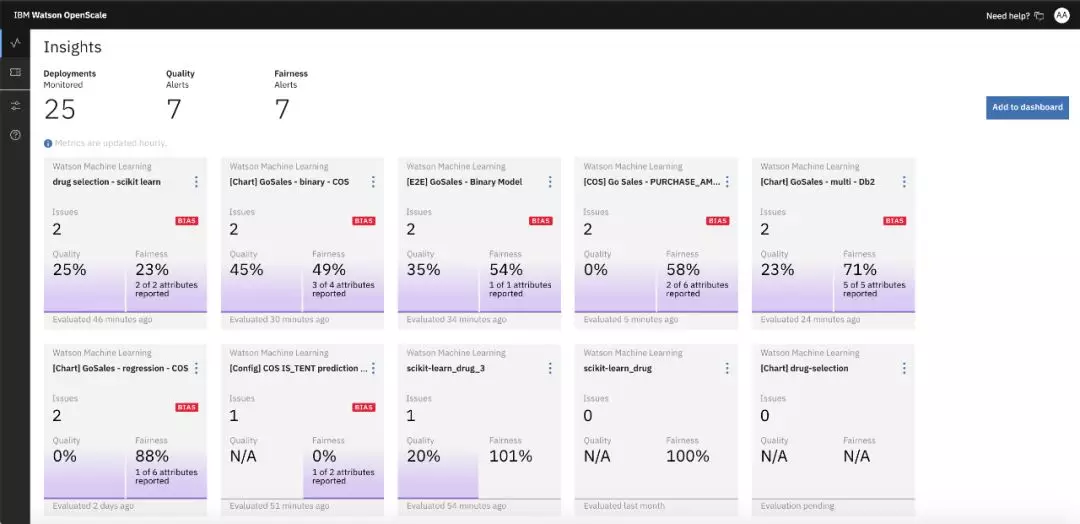

IBM AI OpenScale 技术平台也可以在各种 AI 应用运行时,检测并解决其中的偏见问题。

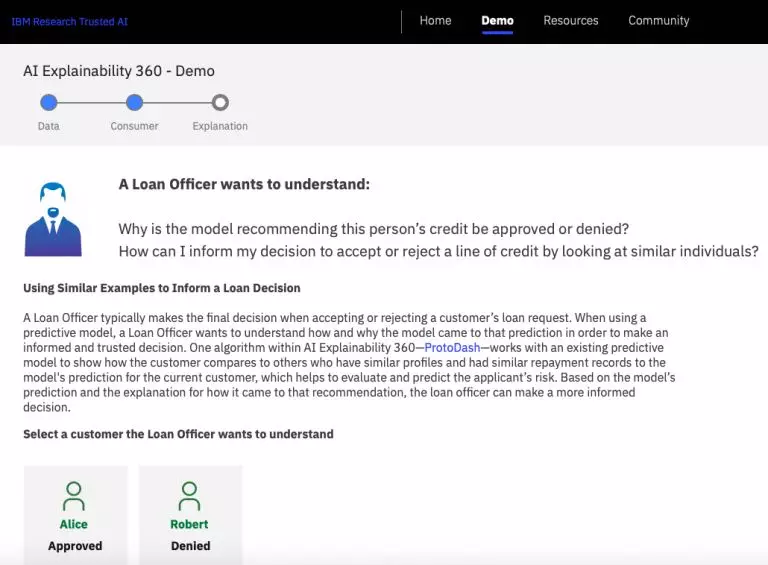

可解释性:尽管机器学习存在着人类难以明白原理的“黑盒”,但在现有已经很成熟的技术和应用基础上,它还是比决策树类“白盒”更具潜力。IBM 倾向于通过同样是基于神经网络的办法,来解释 AI 模型的决策。

2019 年 8 月,IBM 发布开源算法集合 AI Explainability 360,以增强算法的可解释性。

例如,如果手写识别要区分一个手写的图片是数字 3 还是 5 ,该工具可以尝试给出类似这样的解释:

“我之所以没有把它识别成 5,是因为 5 上面还要有小小的一横。如果我看到这一横,我就把它识别成 5 了。”

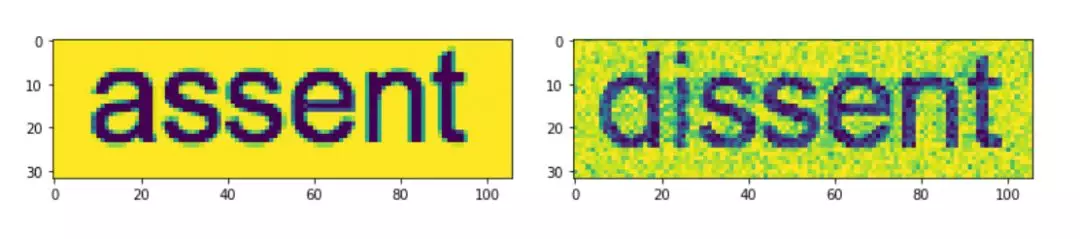

健壮性:开发者往往通过数据集训练图像识别模型。但是如果人为地给原始数据加噪声,进行噪声迭代,就有可能产生一些危险的误导性案例:人看上去还是正确的结果,机器却做出错误的识别。

很多模型如果遭受这样的攻击,后果是很可怕的。比如自动驾驶系统遇到经黑客篡改的交通标志,一旦识别错误,就可能导致交通事故。

Adversarial Robustness 360 Toolkit 是 IBM 研究团队开源的,用于检测模型及对抗攻击的工具箱,为开发人员加强 AI 模型被误导的防御性,让 AI 系统更加安全。

透明性:AI OpenScale 是 IBM 提高所谓“黑箱方法”透明度的一部分,从而加速 AI 的规模化发展。

无论 AI 应用在何种环境中构建或运行,AI OpenScale 都可让企业在其整个生命周期中实现透明化管理,记录每项预测、每个模型版本、所有使用的训练数据及各种指标,帮助企业遵守 GDPR 等法规。

可信 AI 的未来展望

在 IBM 提出“智慧地球”概念的 2008 年,就提前预测了万物互联的现实演变。这也使得采纳 IBM 智慧城市改造方案的案例,都体现了 AI 强力工具的正确“打开方式”。

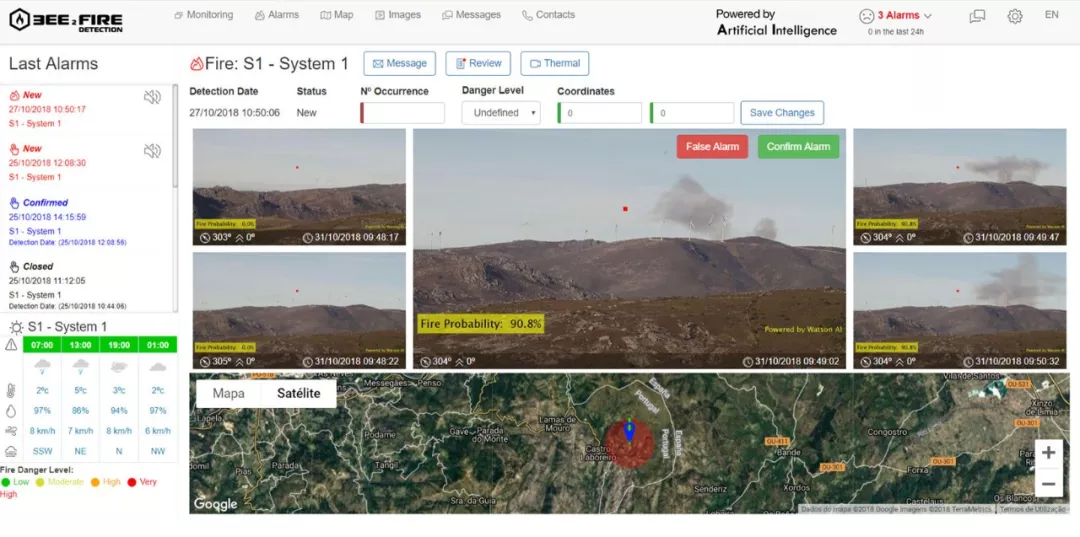

例如,面对全球变暖导致的森林火灾风险提升,葡萄牙公司 Compta 与 IBM 合作,构建了名为 Bee2FireDetection 的新型火灾检测解决方案,利用 AI 来提高自动化程度并加快决策,减轻欧洲和北美的林火风险。

该工具最远可发现 15 公里范围内的火灾,可在森林火灾发生后的前 20 分钟内检测到,实现早发现,早扑救。它使用来自 The Weather Company 的数据,计算未来几天的火灾风险水平,并分析出现火灾时可能的蔓延方式。

在 IBM 及业内其它公司的共同推动下,值得信赖的人工智能将成为今后 AI 发展的焦点所在。世界各国也都开始重视 AI 的安全可控问题,并以不同形式加以规划和治理。

近日,由国家科学技术部、工信部、交通运输部、教育部、中国工程院等单位人士牵头组成的国家新一代人工智能治理专业委员会,发布了《新一代人工智能治理原则——发展负责任的人工智能》。

在其提出的“和谐友好、公平公正、包容共享、尊重隐私、安全可控、共担责任、开放协作、敏捷治理”等八条原则中,同样体现了 AI 设计需要安全可控可靠、公平公正、尊重隐私等要点。

谢东在演讲中提到,虽然 AI 让我们深刻思考其可信性问题,但也不需要为此过分焦虑。这也是 AI 发展过程中不可避免的环节,重点在于相关方面的正义感和责任感。

他引用 IBM 董事长罗睿兰的话说:

“人工智能正在全方位地影响和改变整个社会。IBM 致力于 AI 的研究和应用,为企业提供先进和完整的 AI 技术和方案,并致力于打造可信任的 AI,而社会也会选择它所信任的公司。”

喜欢我的作品吗?别忘了给予支持与赞赏,让我知道在创作的路上有你陪伴,一起延续这份热忱!