自製全網站備份工具,歡迎使用(零資源佔用,一鍵備份)

【如何使用】

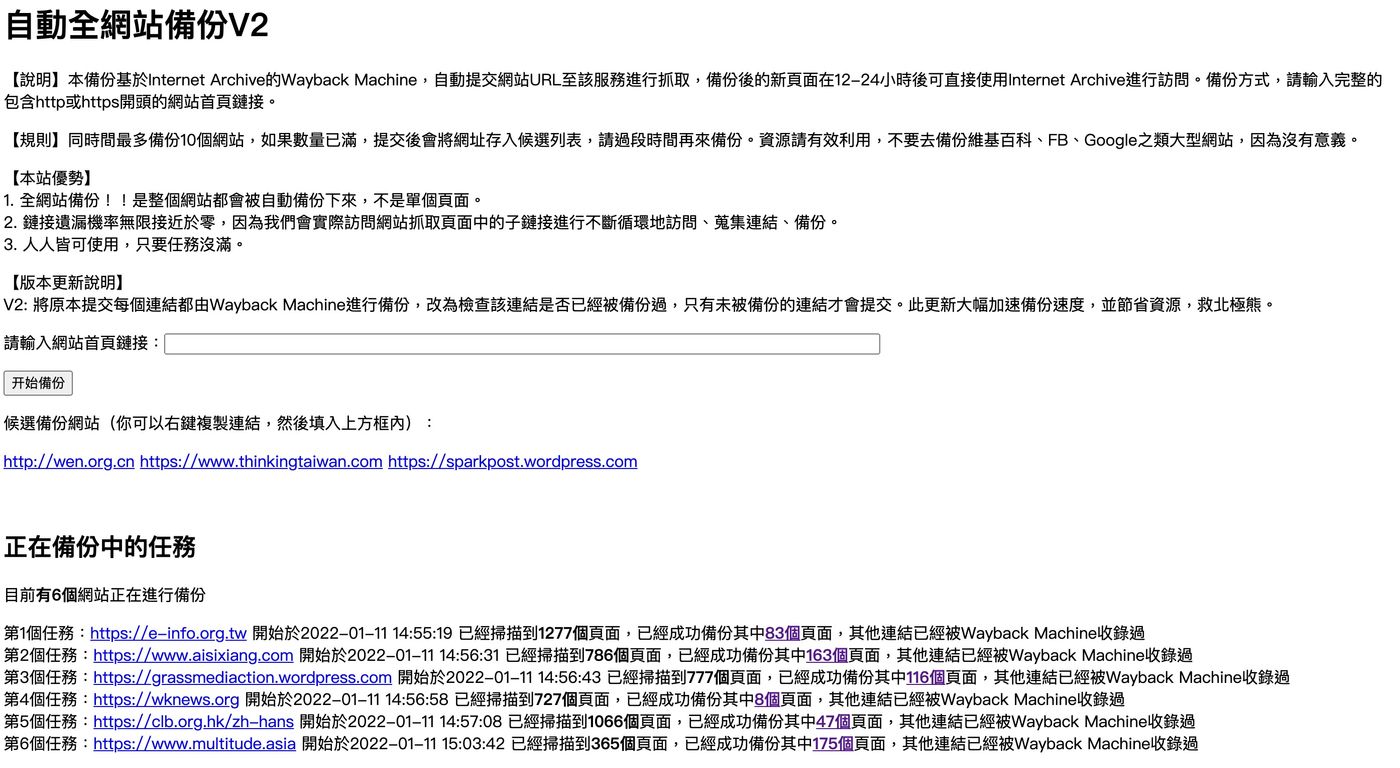

進入:https://datalabour.com/saveWeb/

- 找到中間的輸入框,輸入完整的包含http或https開頭的網站首頁鏈接,然後點按鈕「開始備份」即可。

- 同一時間最多10個備份任務,如果任務已滿,提交後會將網址存入候選列表,請過段時間再來備份。資源請有效利用,不要去備份維基百科、FB、Google、Twitter之類大型網站,因為沒有意義。

- 可以備份任何網站,適合未雨綢繆地保存一些舊的blog、社運網站、社區網站、獨立新聞媒體、NGO網站等等。

【它怎麼運作】

這個服務與httrack或者wget等直接將網站下載到你的本地硬碟的方式不同,我們依靠Internet Archive的Wayback Machine進行運作。

Internet Archive是全球最大的互聯網檔案館/圖書館,儲存了數以百億計的網頁。雖然過去曾遭遇火災,但因為Internet Archive出色的多地備份,而沒有任何資料損失。Internet Archive的Wayback Machine類似於Google或百度或Bing的爬蟲,會自動搜尋網路上的網站內容進行抓取,並提供給所有人訪問或下載,基本不設限制。

不過,因為資源有限,也因為Internet Archive位處美國,主要運營者都是英語使用者,Internet Archive對於中文世界,尤其是小眾的網站的備份仍有缺乏。

所以,本網站的運作方式是:我們會循環抓取(使用文本瀏覽器lynx)你提供的網站的所有頁面連結,並詢問Wayback Machine是否抓取過該頁面。如果沒有抓取過,我們會提交申請進行抓取。直到所有網站頁面都被詢問完成。