Day3 DS review - import datasets, programming with dplyr

好

我们要来import data 了

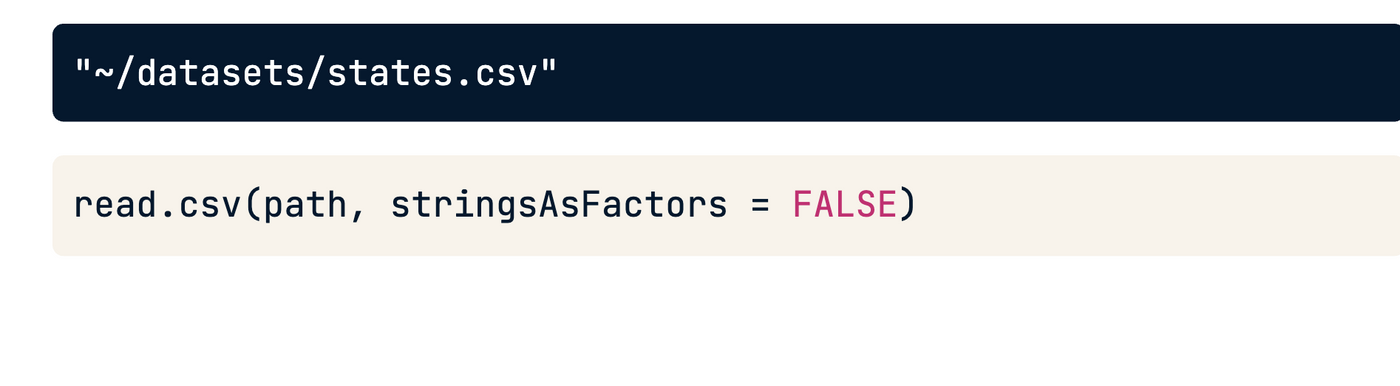

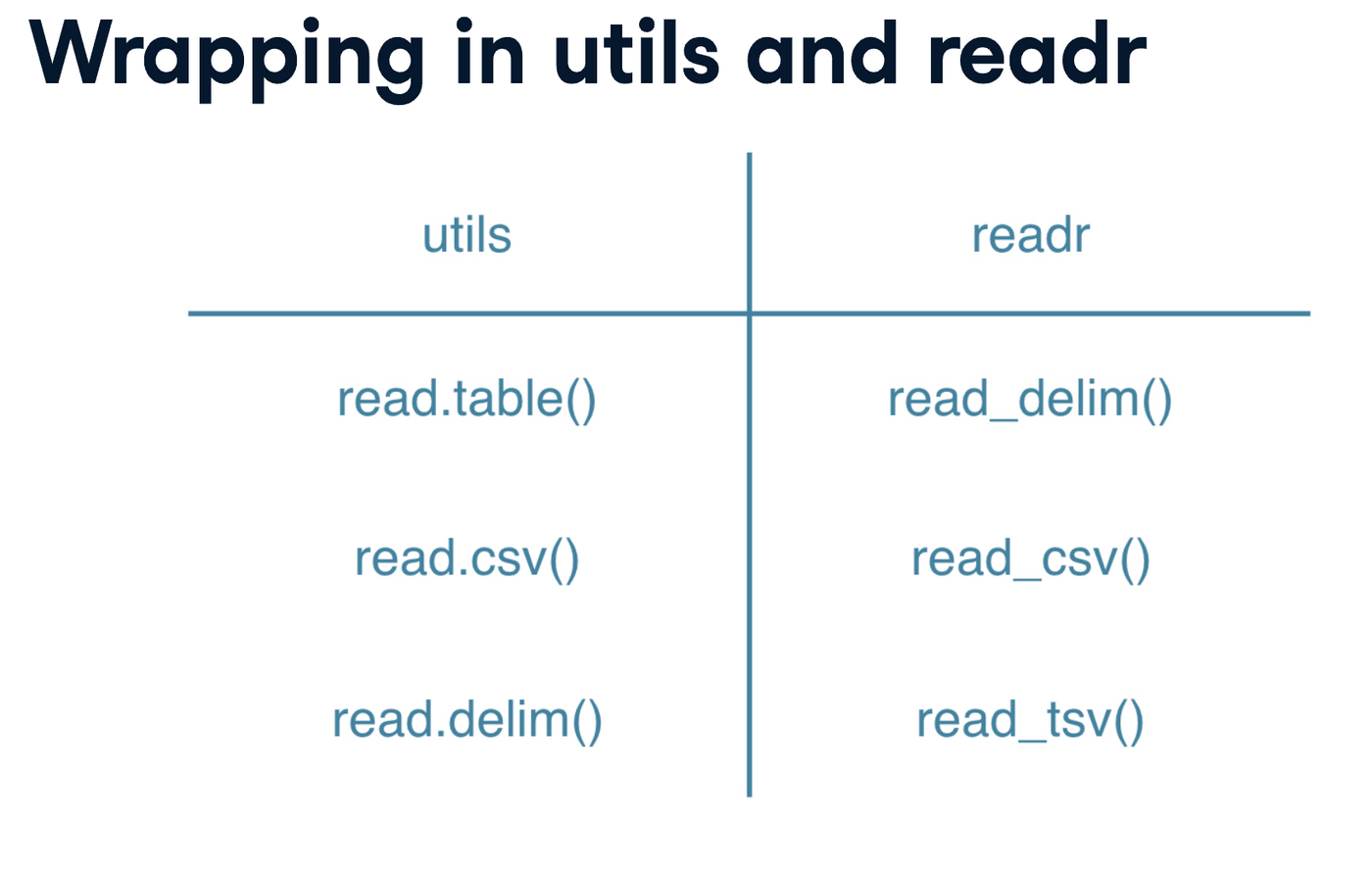

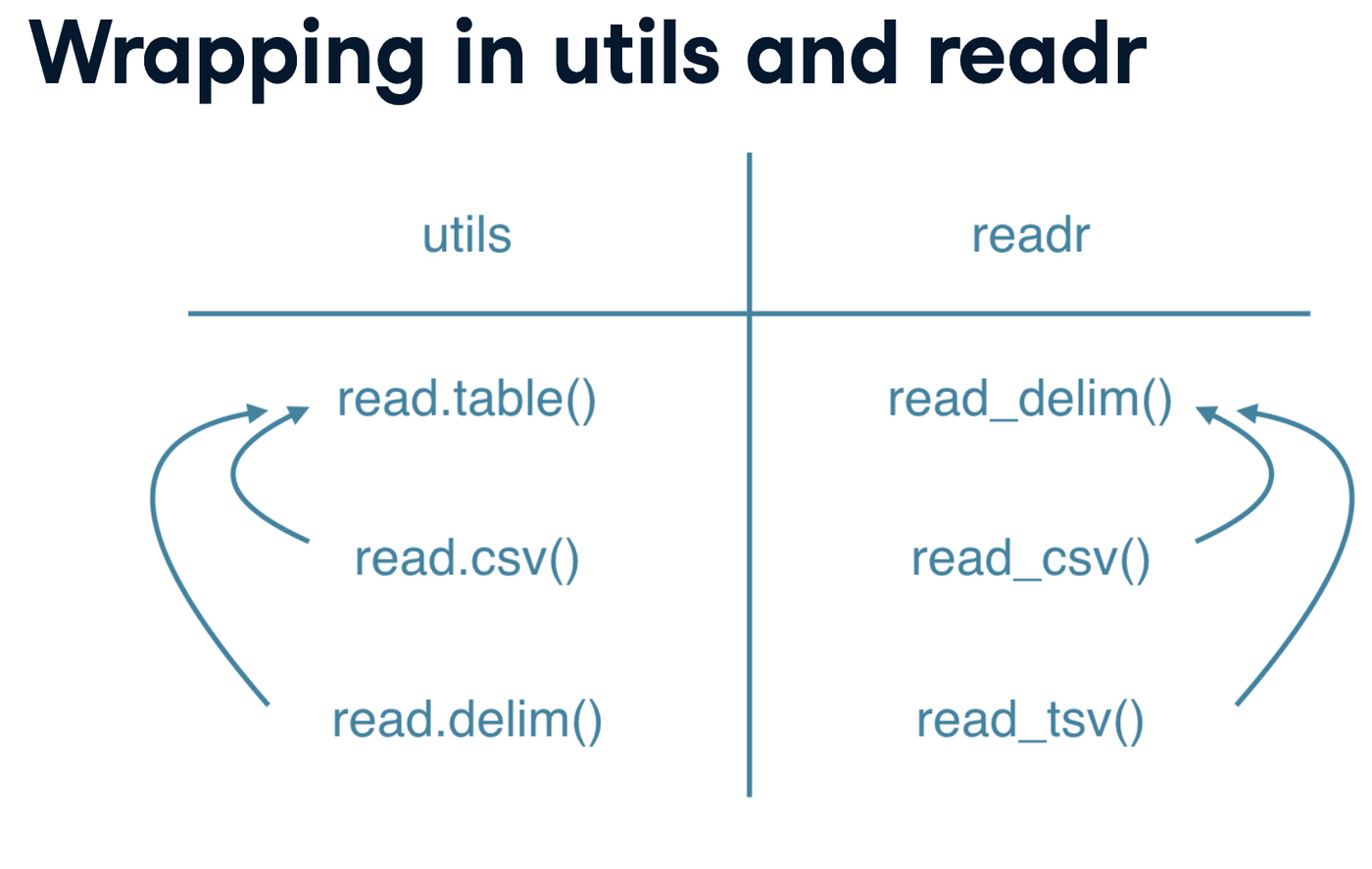

这个是utils,自带的,啥也不用装

. 系列

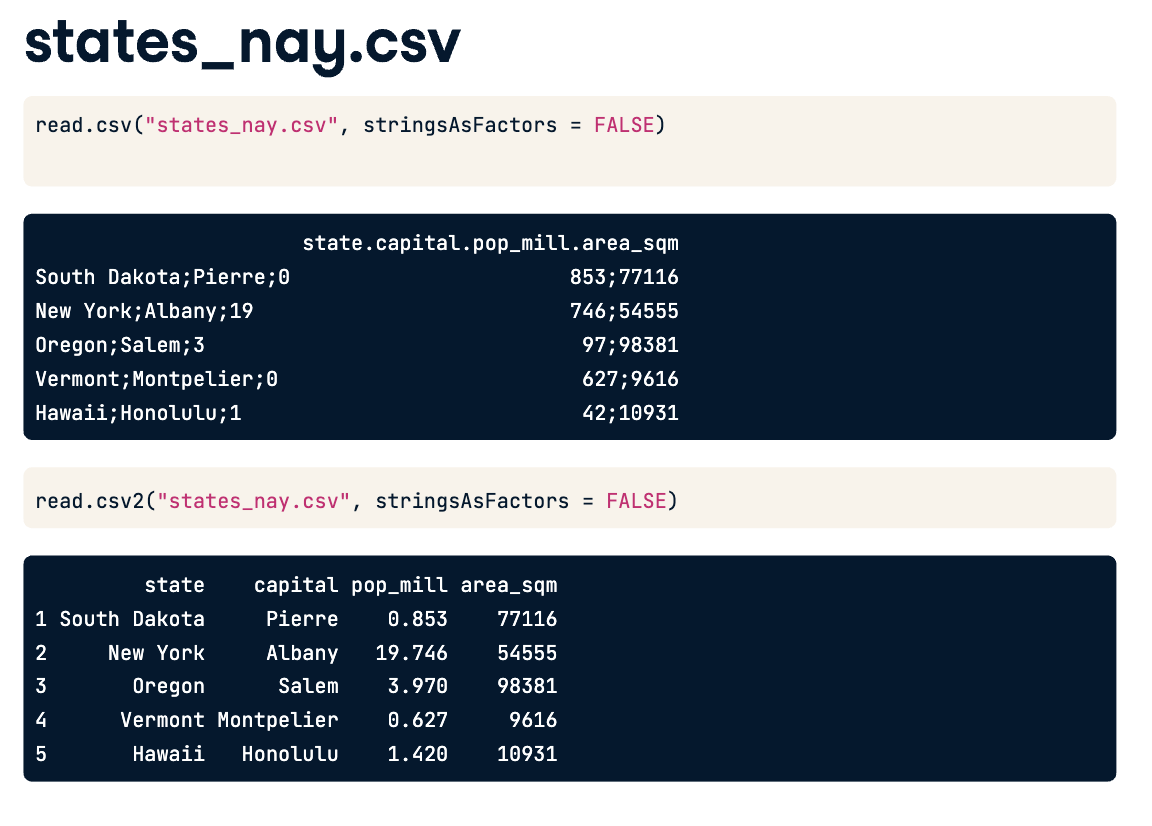

基本上看看read.csv 和 read.csv2 的區別,我也说不上咋区别了,但是吧,就是有区别

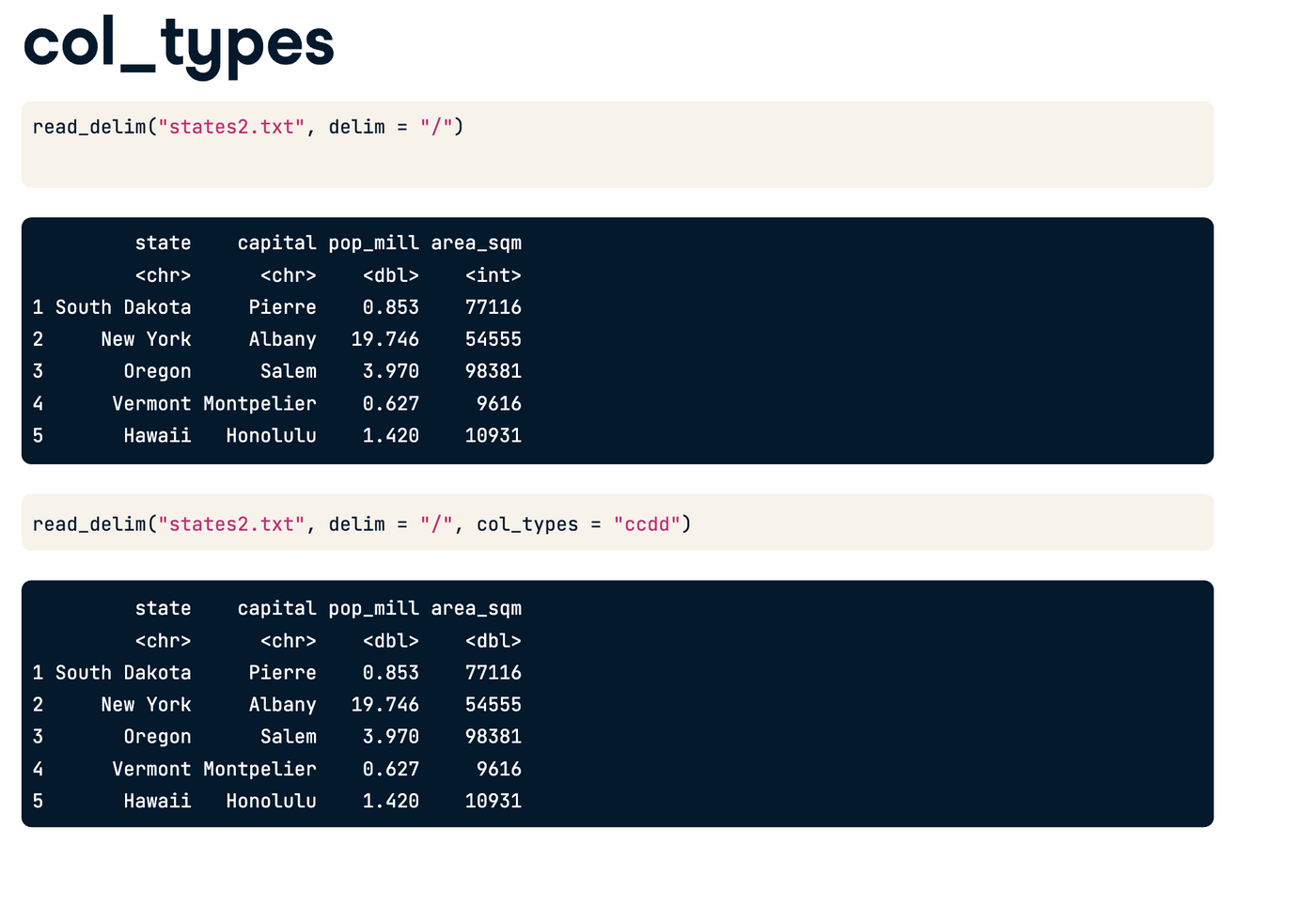

readr 一生推?

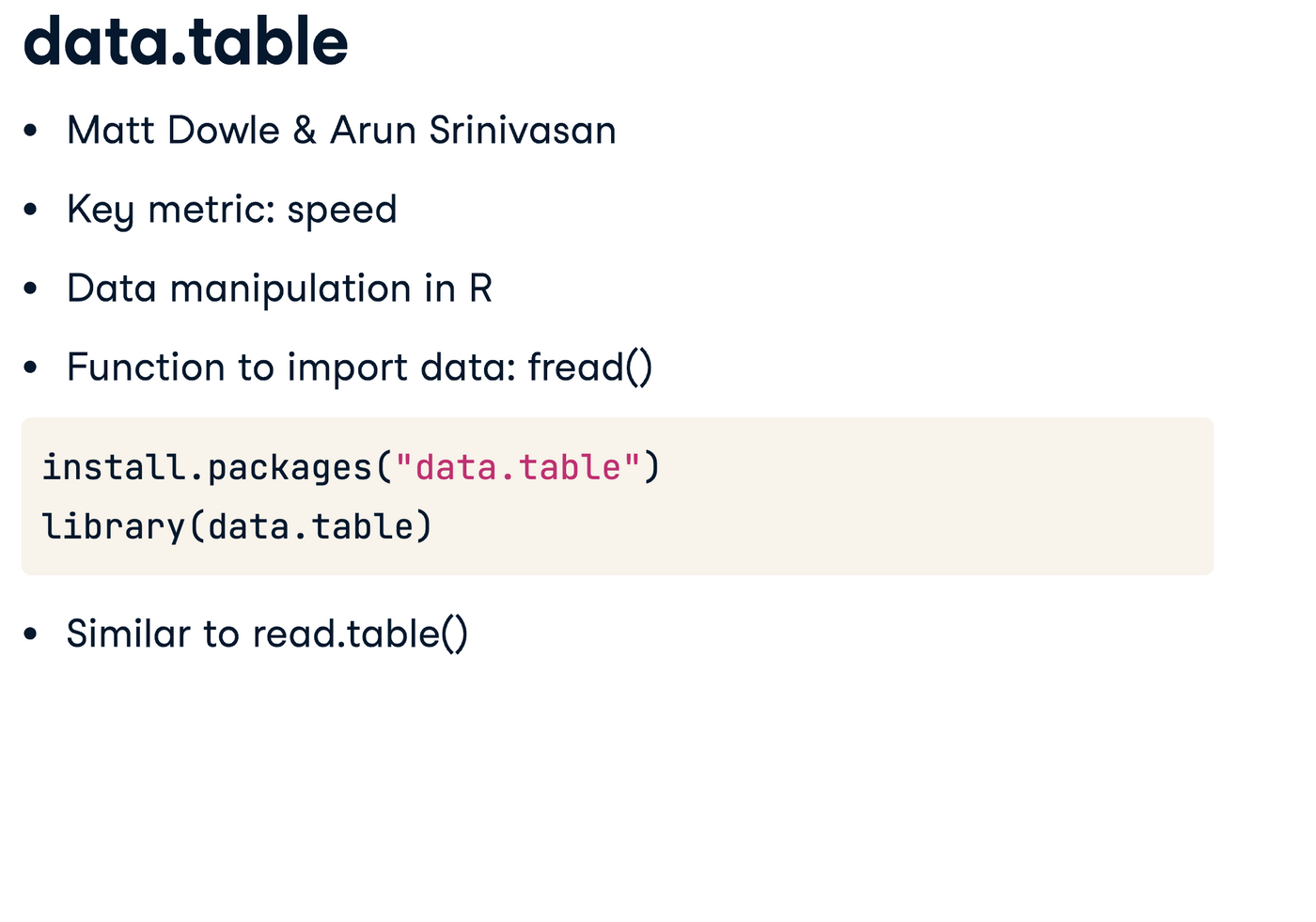

传说中的fread

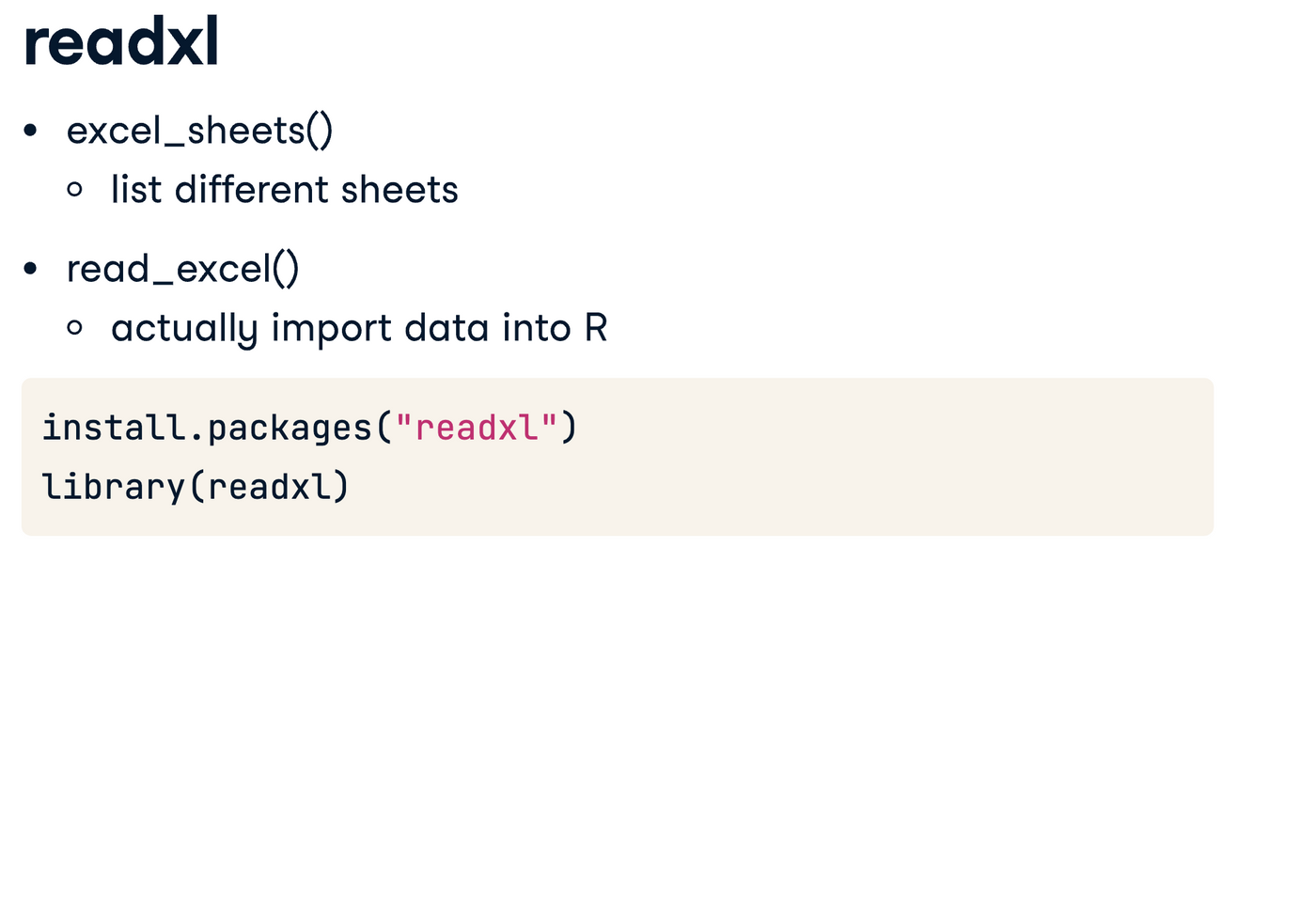

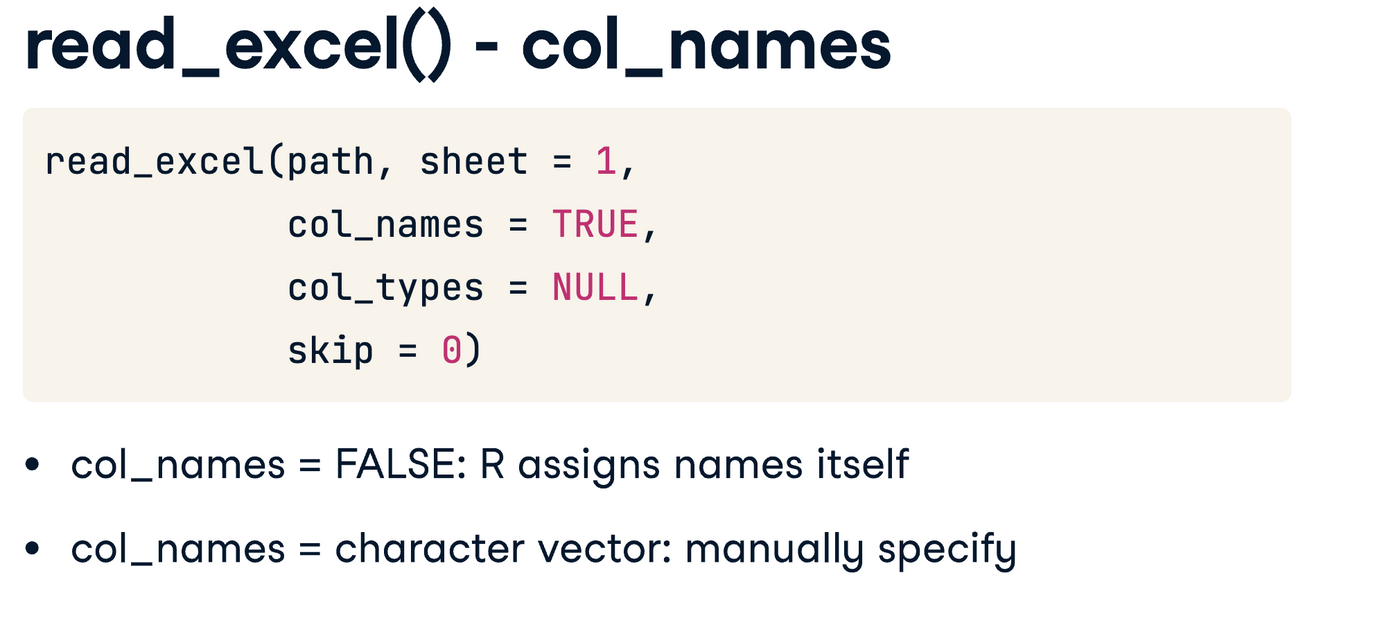

好像带hypfen的都比较不错, 但是要load readxl

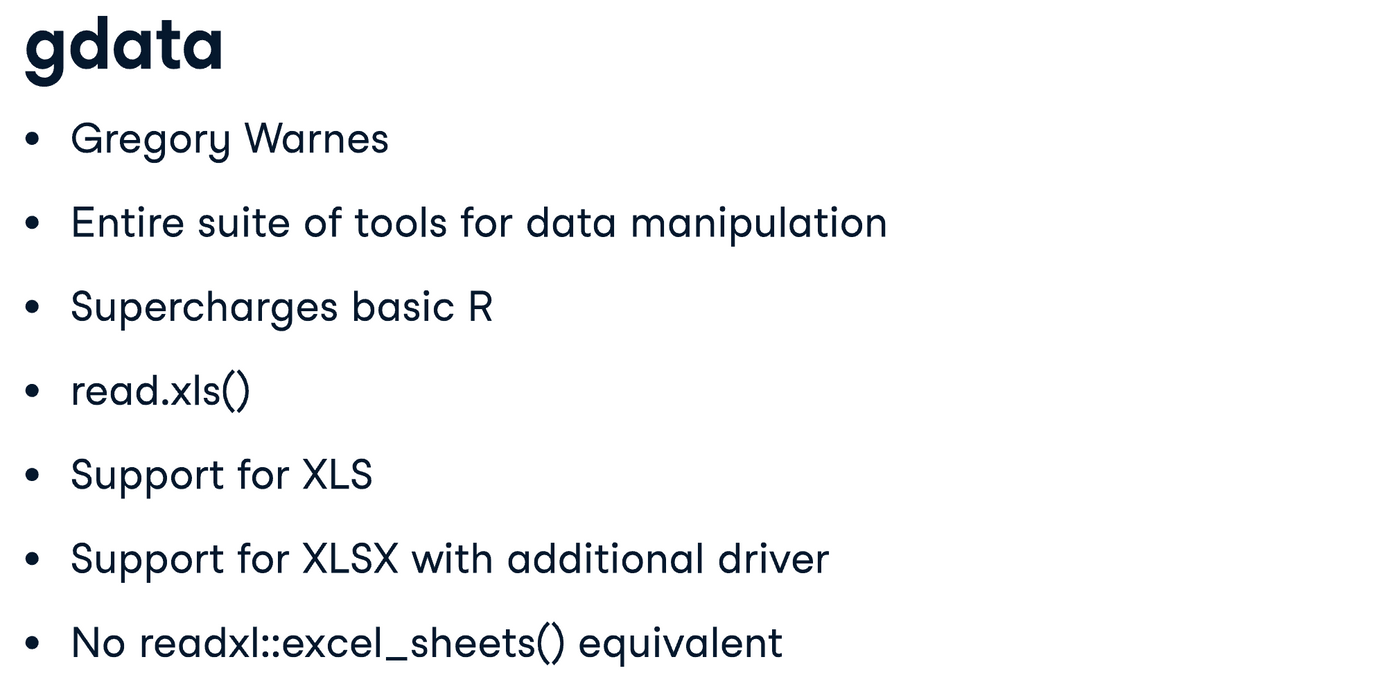

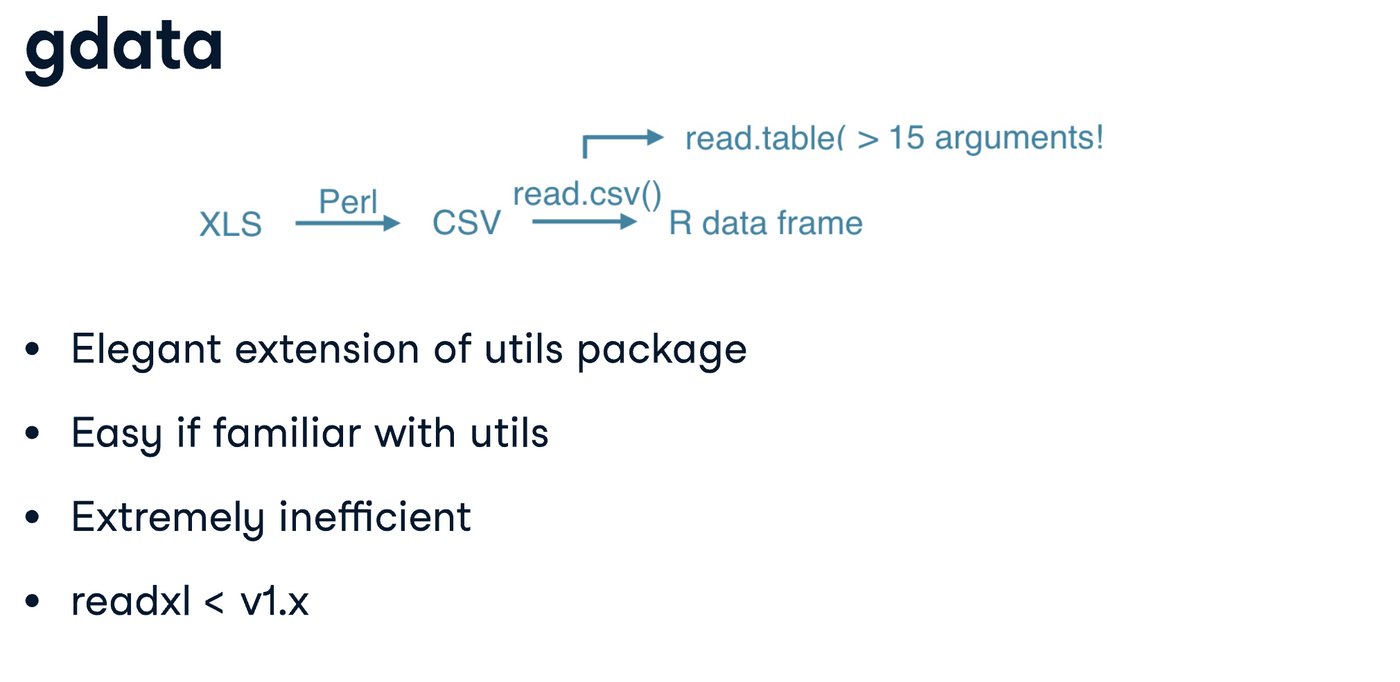

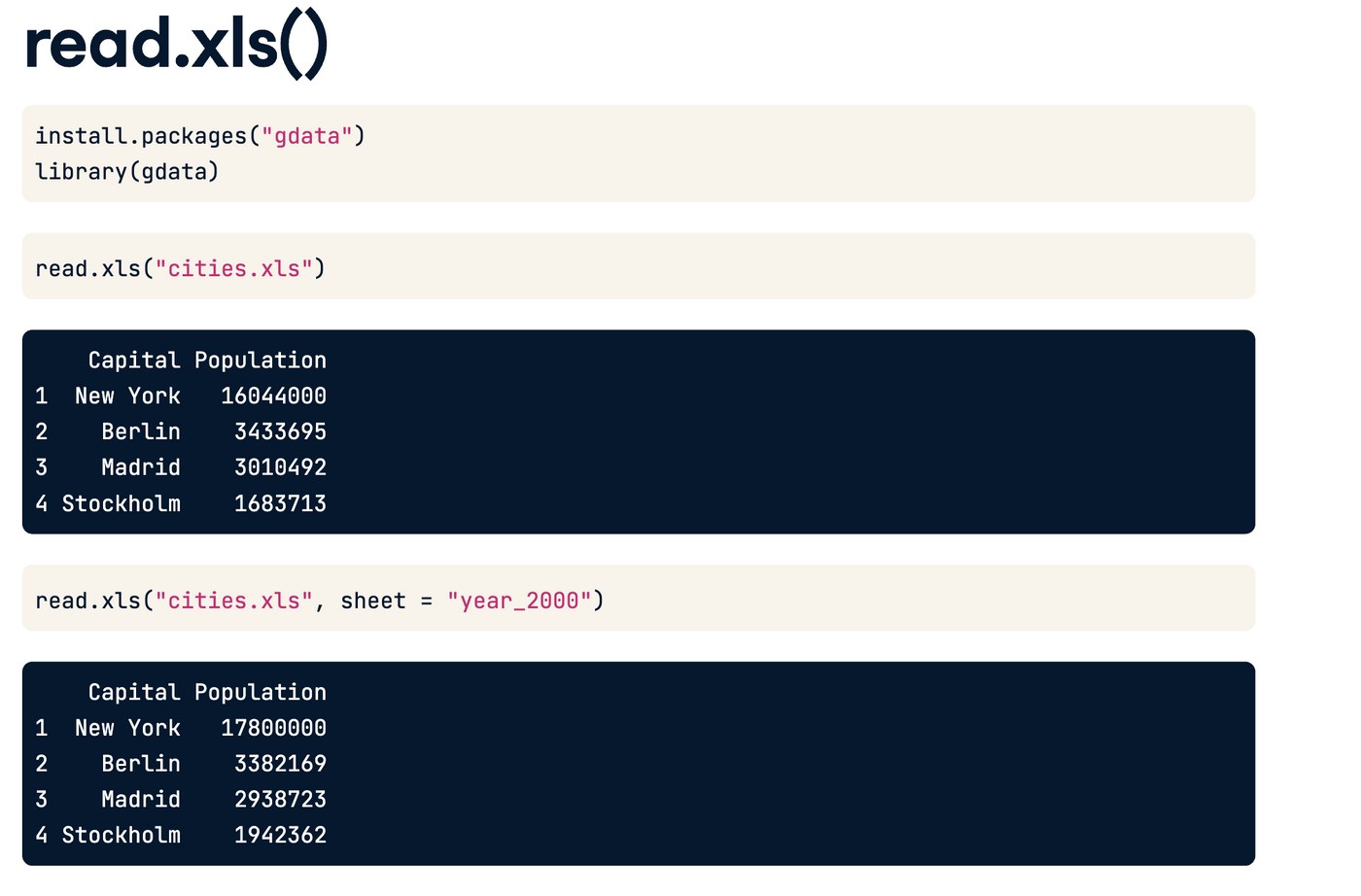

辣鸡的gdata

gdata 听说很垃圾

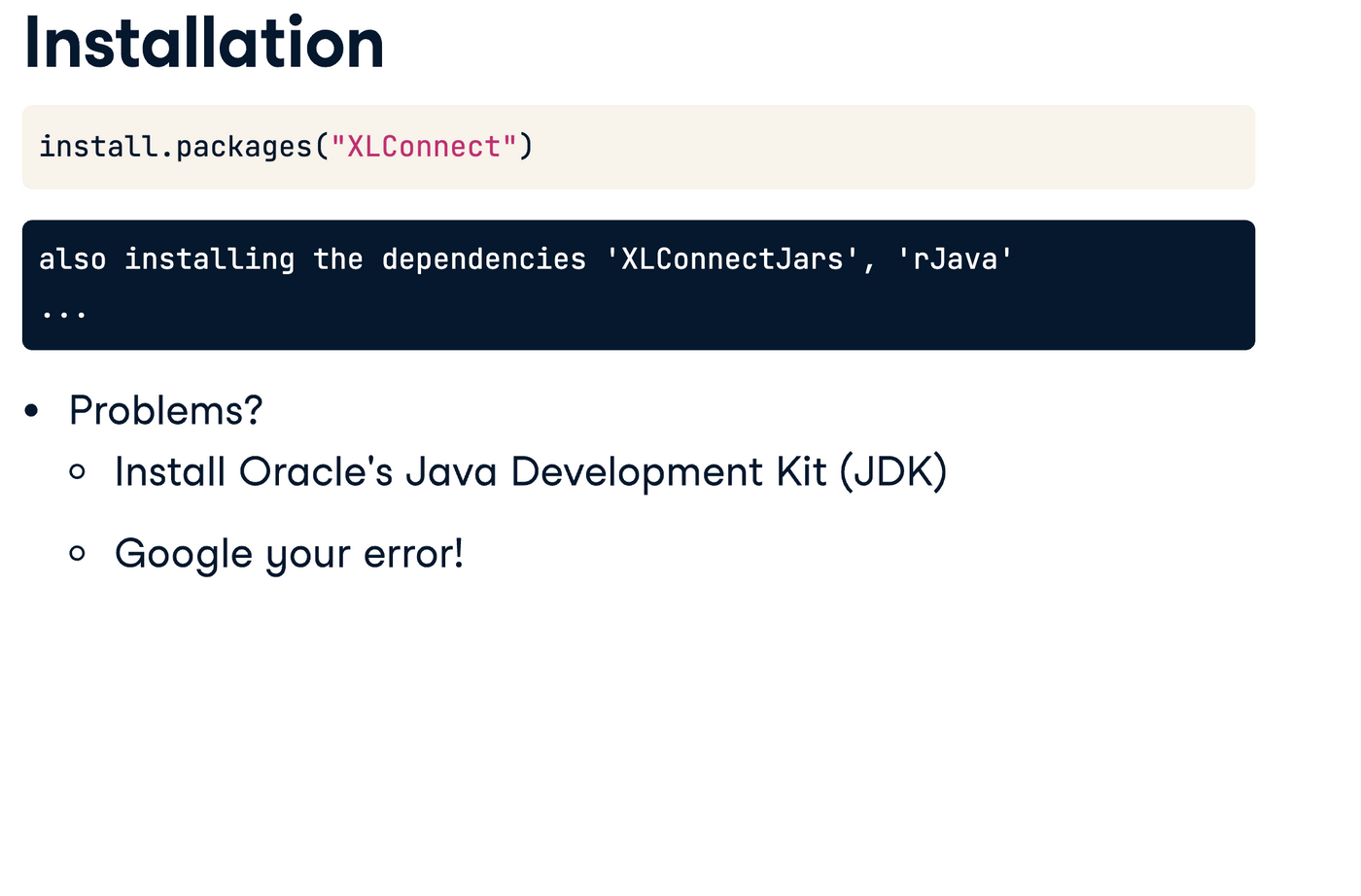

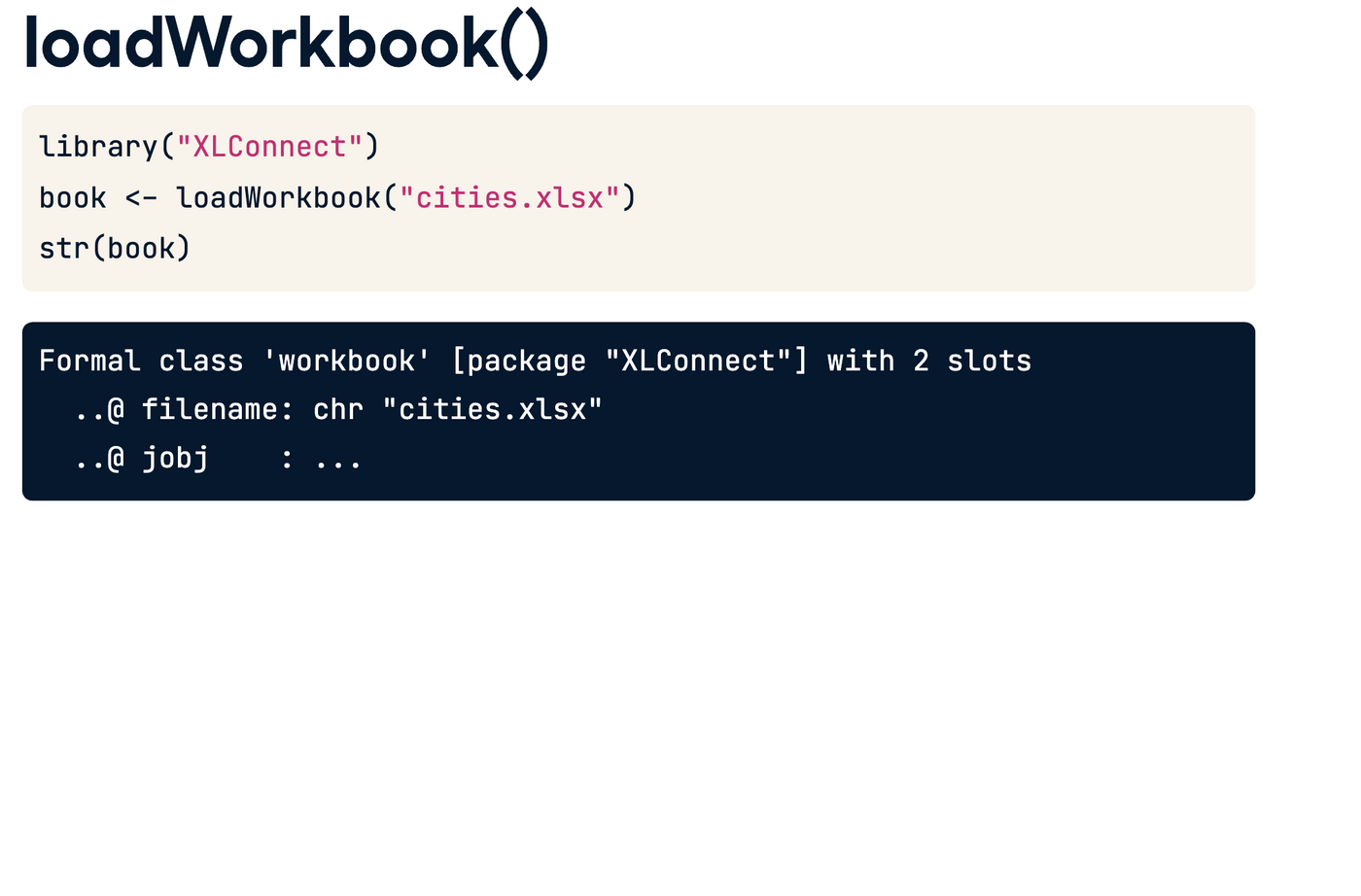

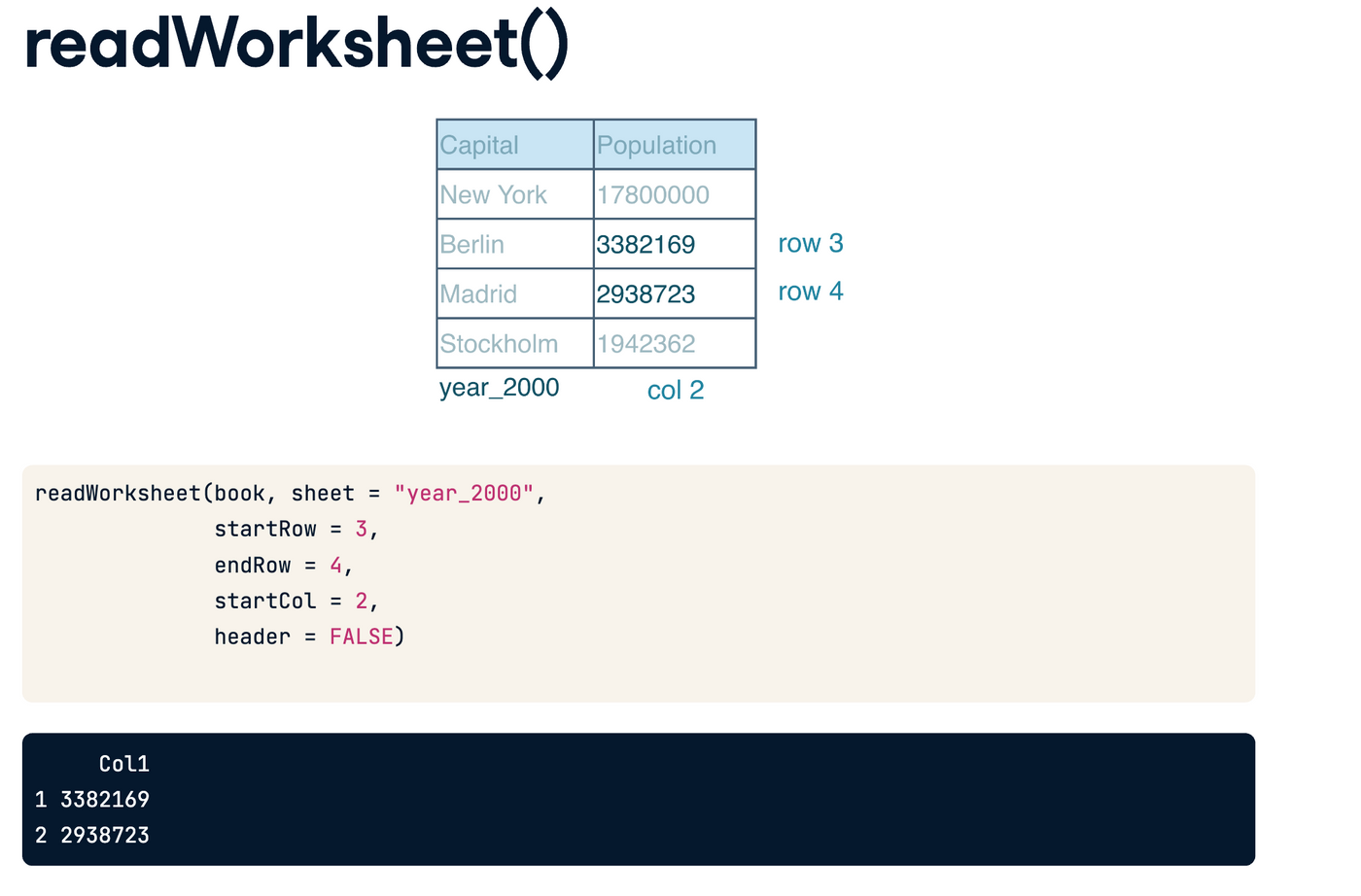

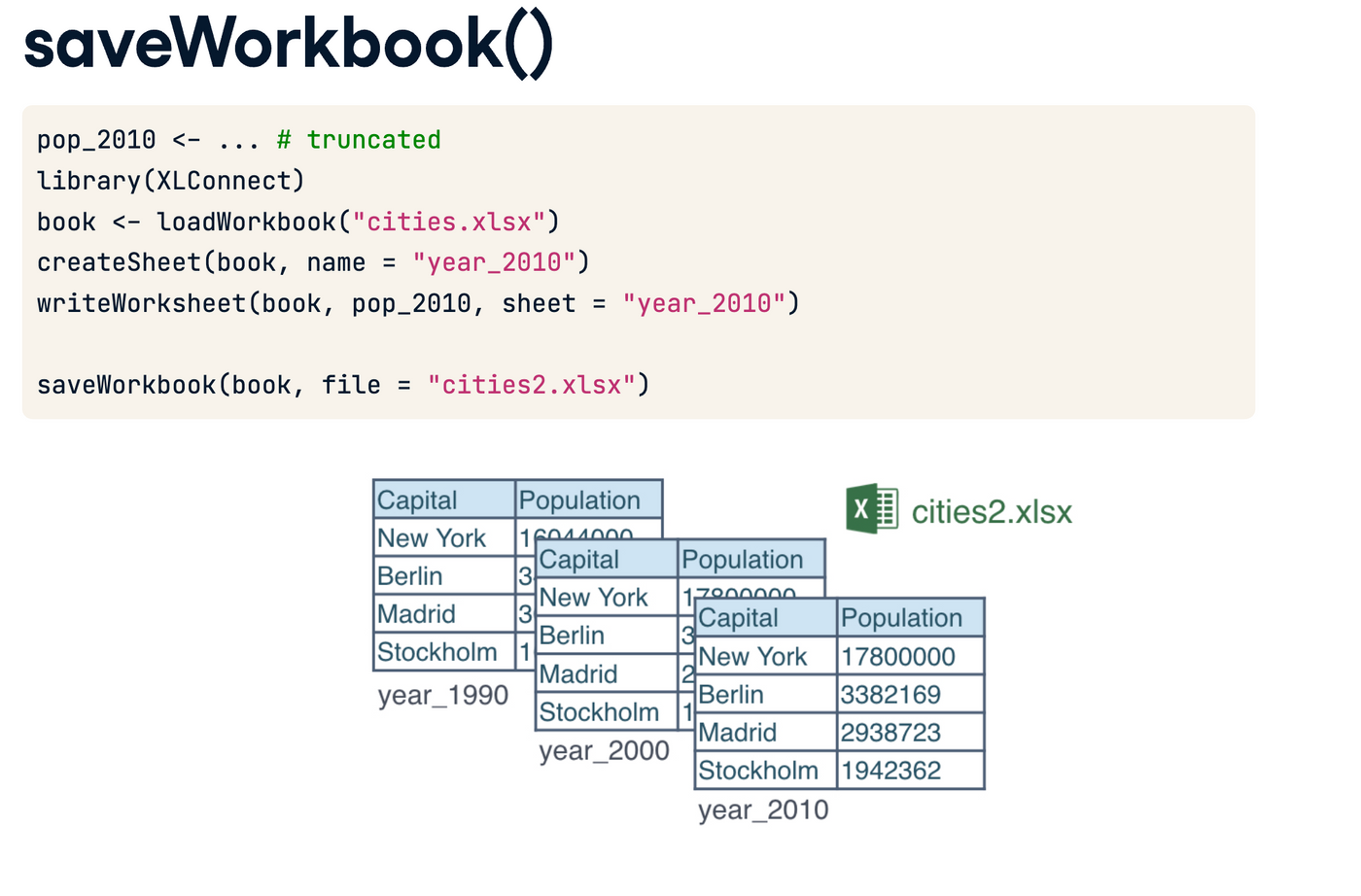

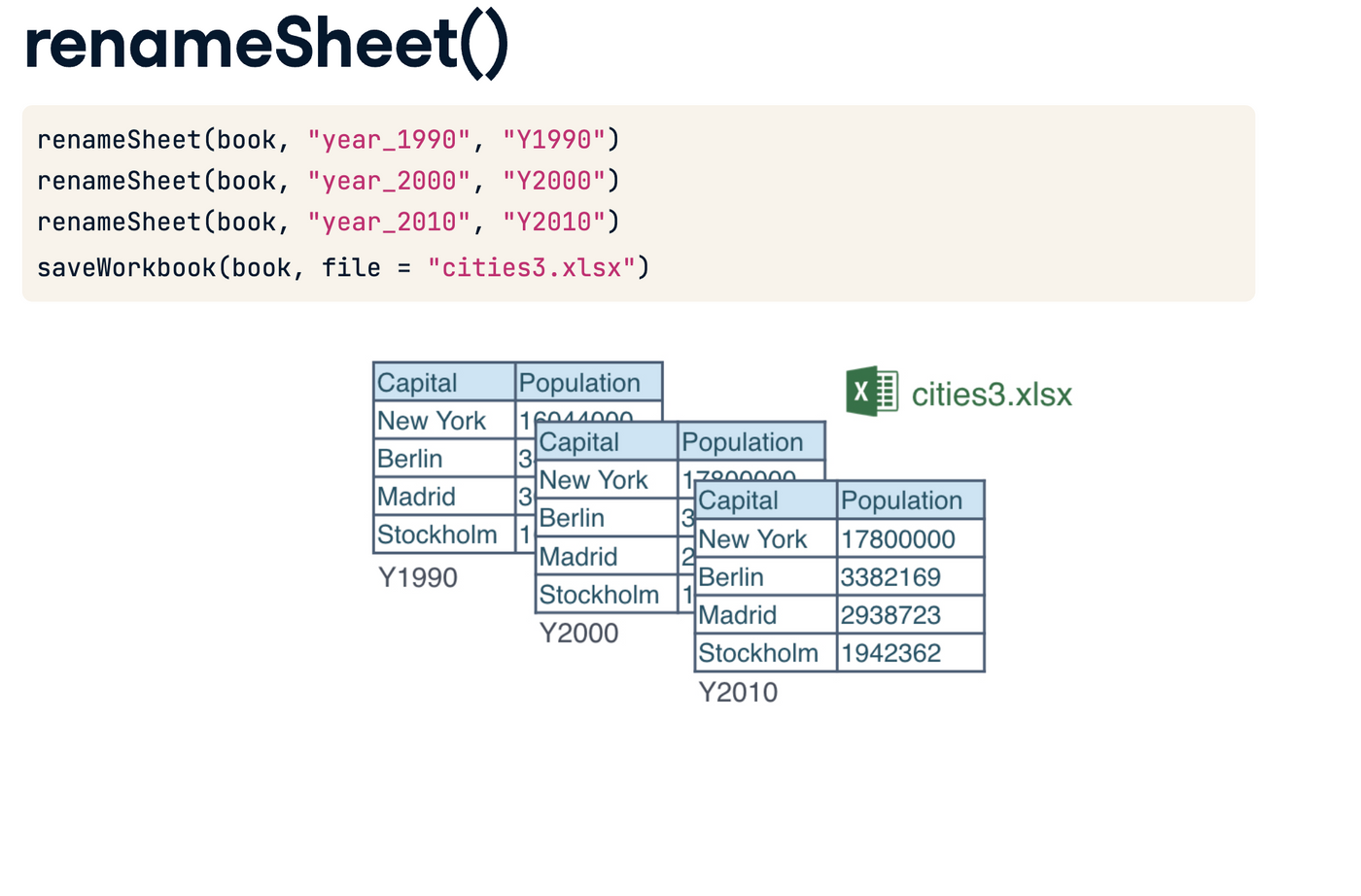

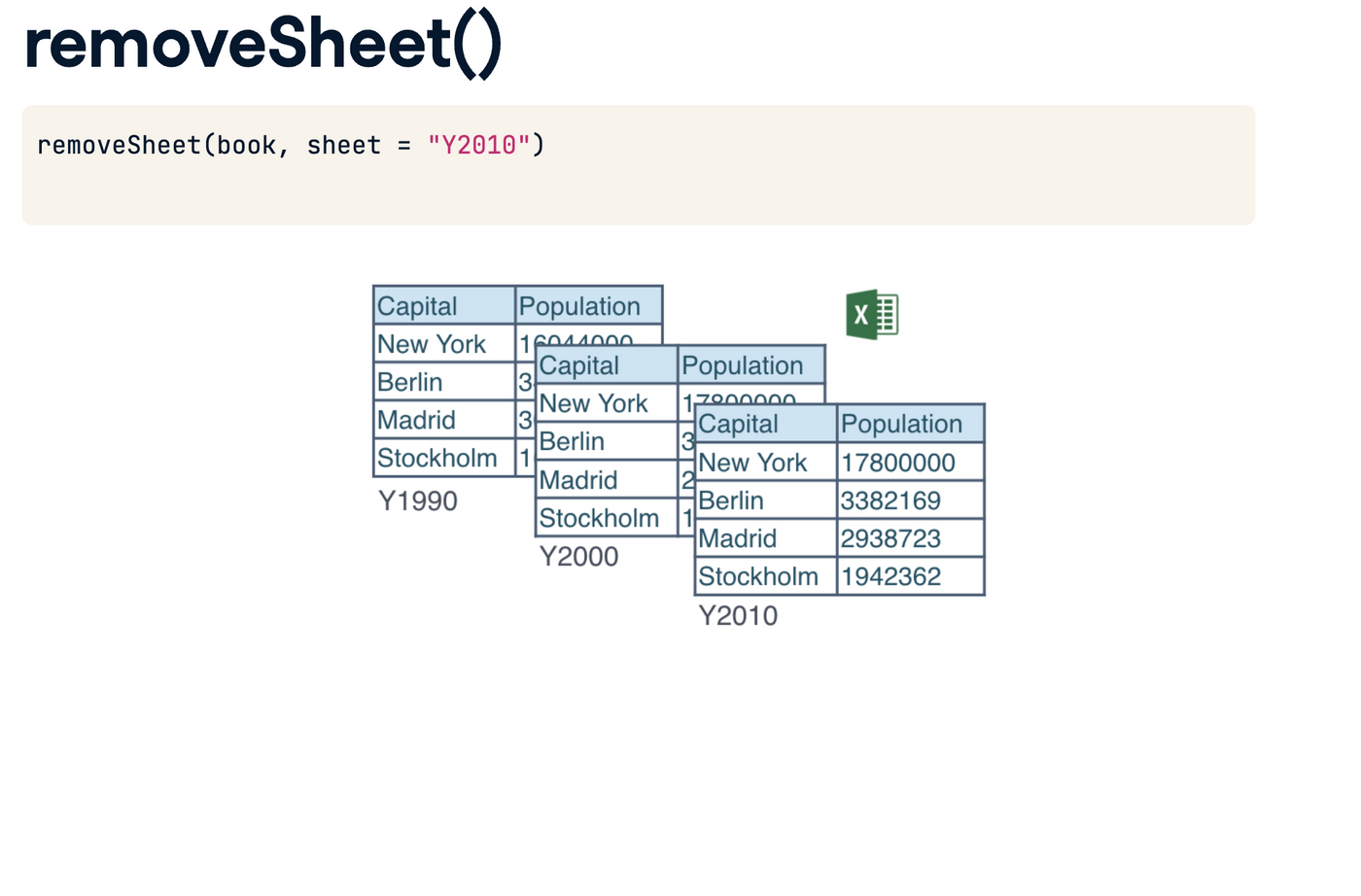

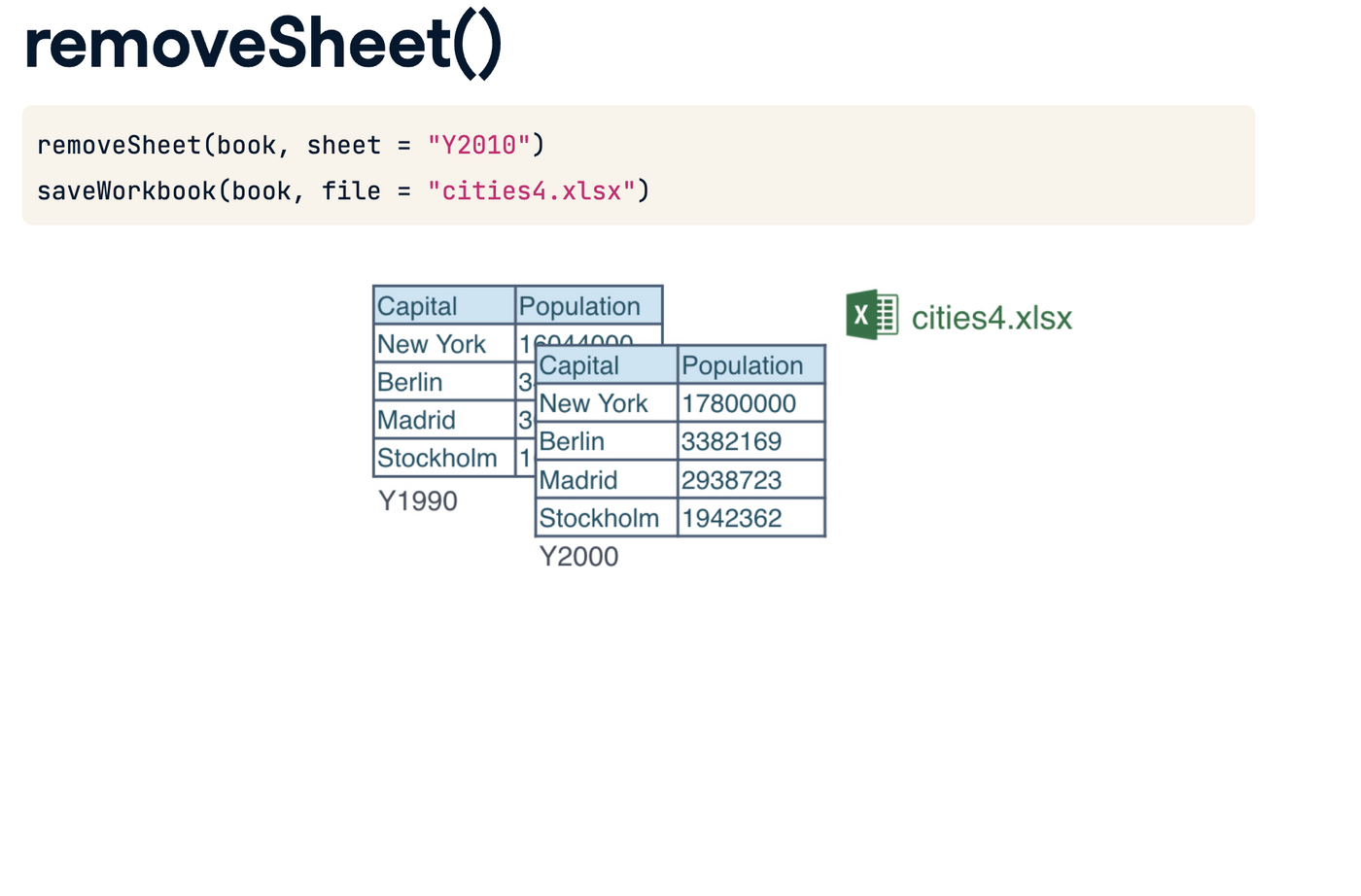

XLconnect 搞Excel - 把RG的那个list 用r整理出能用的list 可能会用上XLconnect

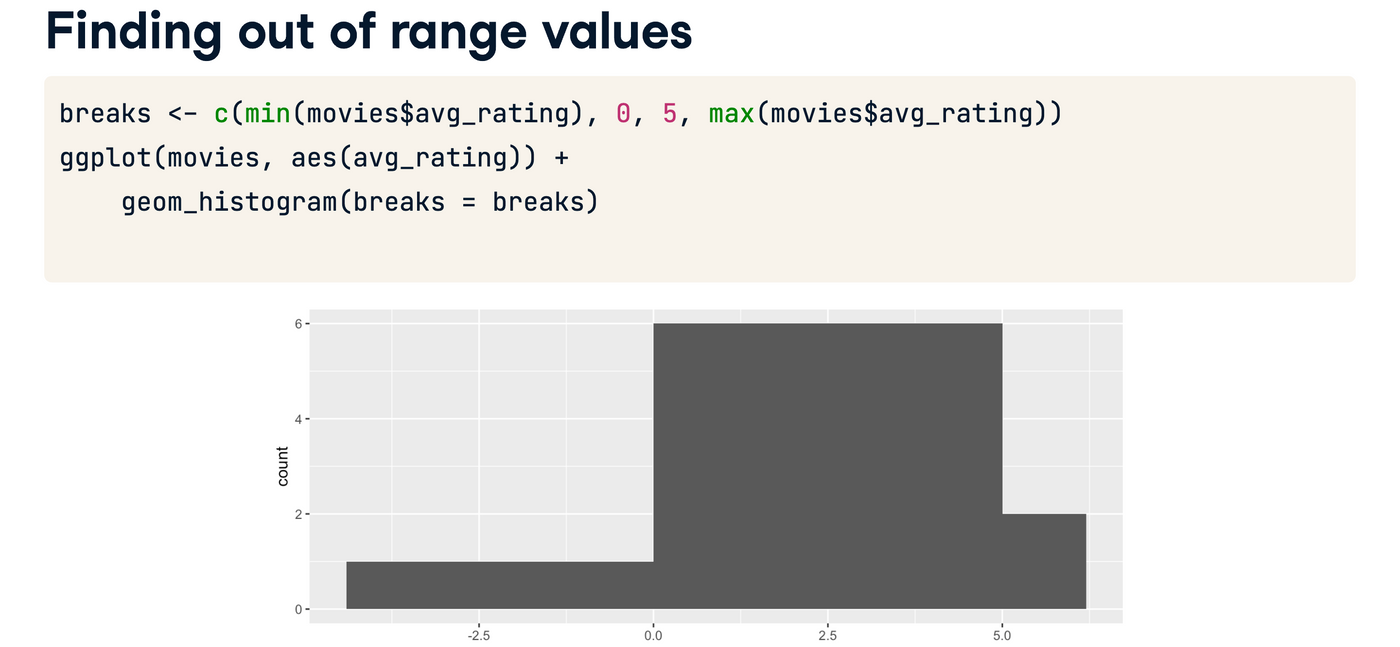

ggplot breaks 的用法很特殊,特此一记

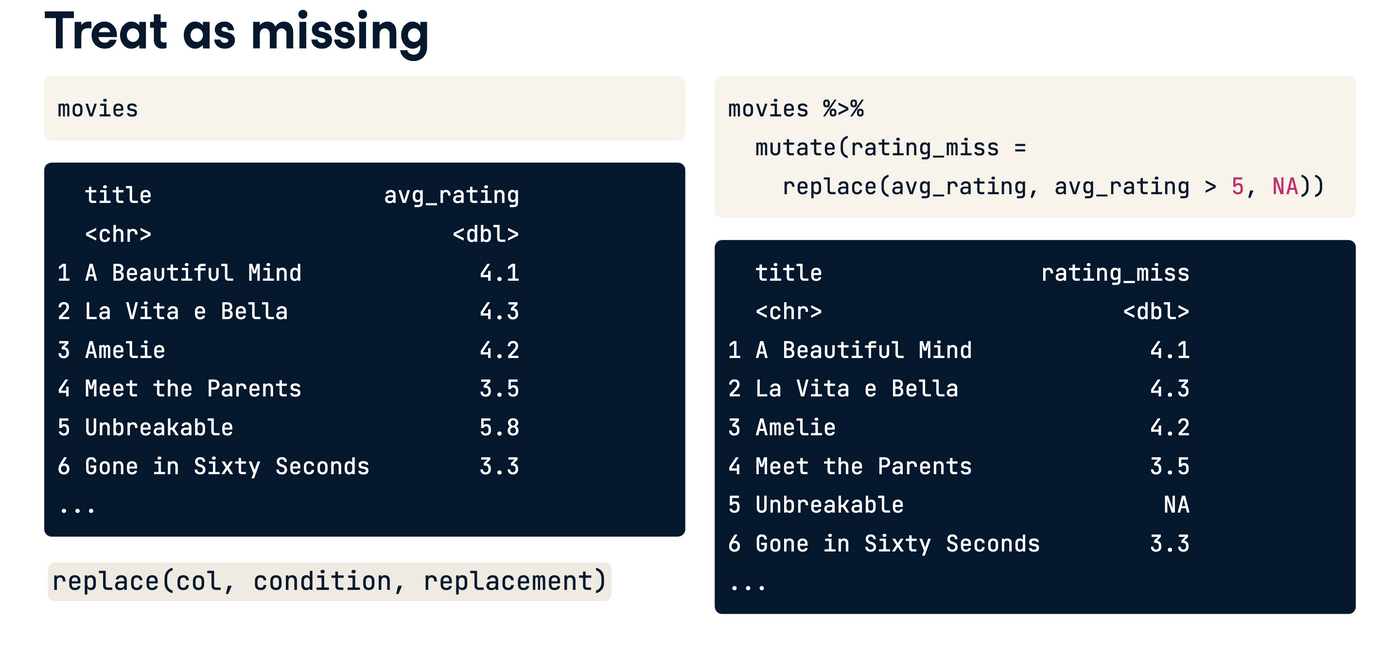

replace 还有missing value 记得有一个课讲missing value 讲得特别好,但是我忘了是啥课,好像是和sentiment analysis有关的,可能是tidy verse toolbox

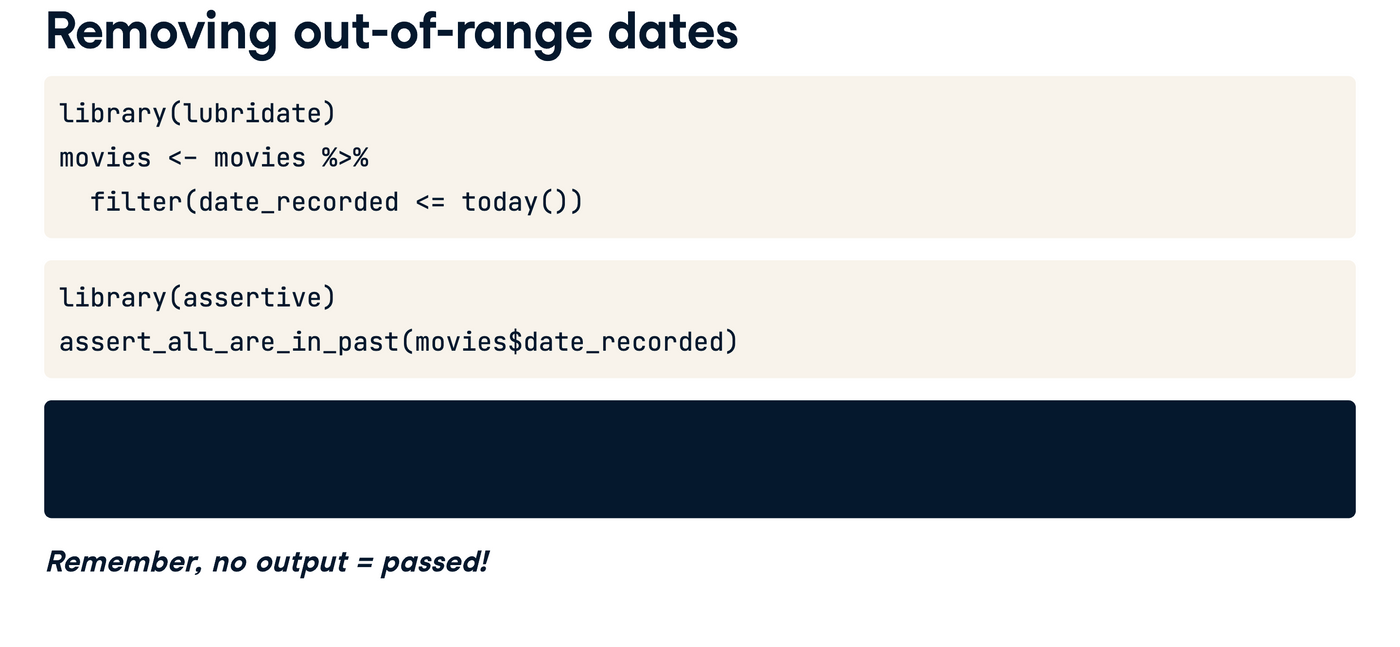

no output=passed

但是要用filter

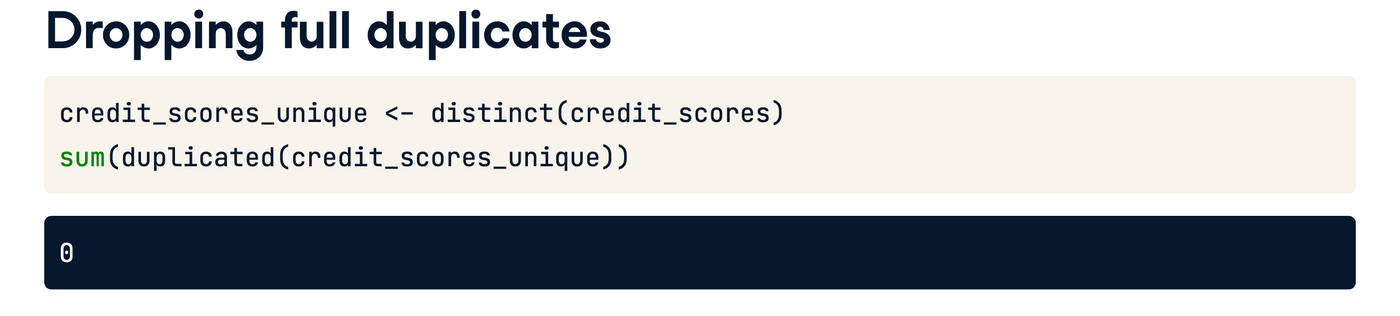

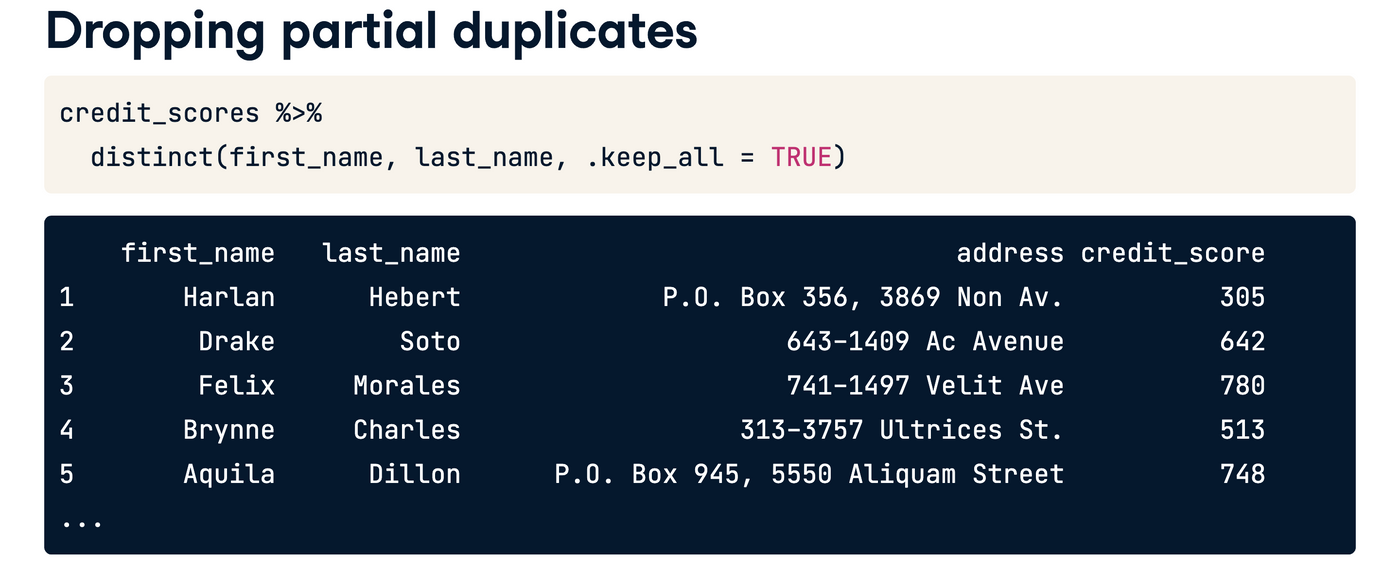

dropping full duplicates 好简单哈哈哈哈就是个distinct,但是data.table里好像有更复杂的解

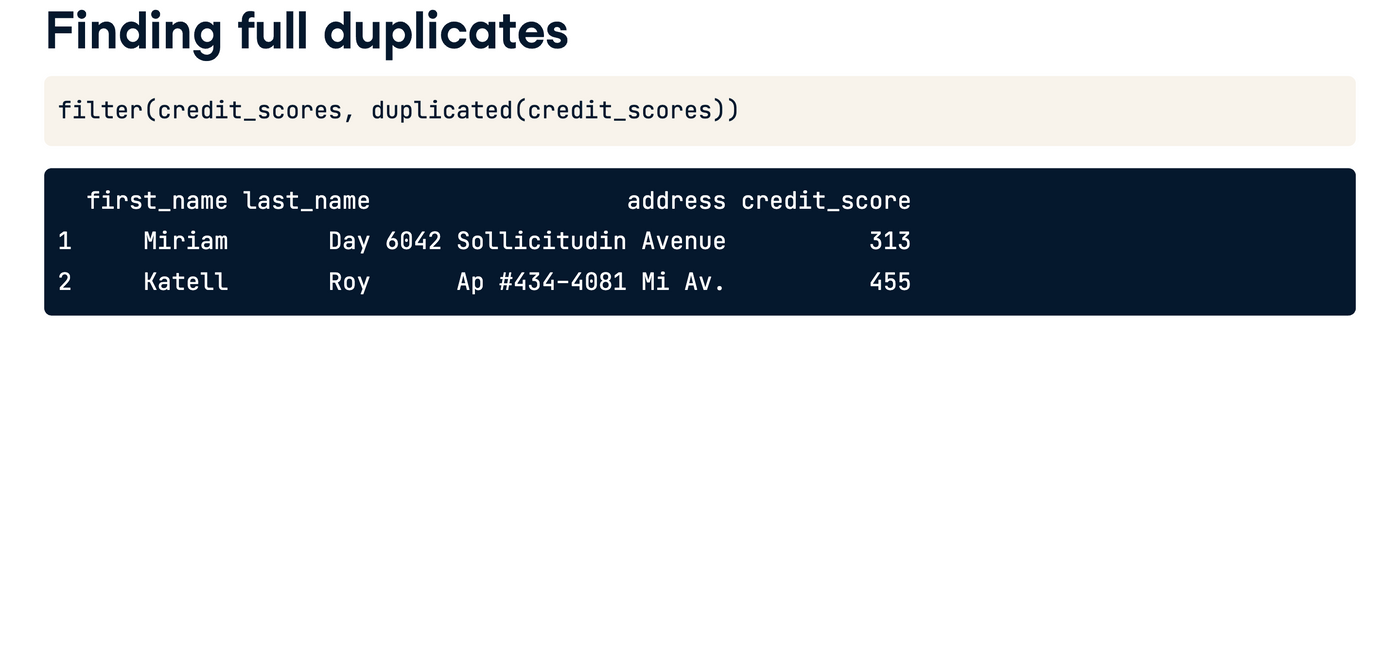

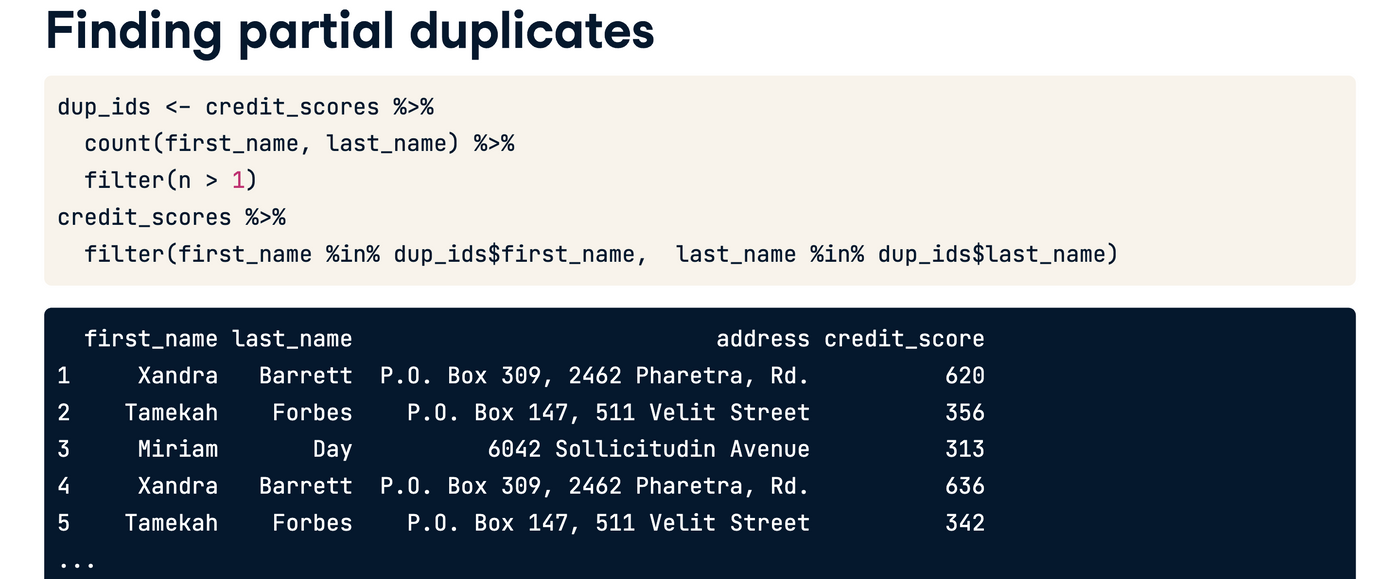

找重复 也有万金油

万金油呵呵

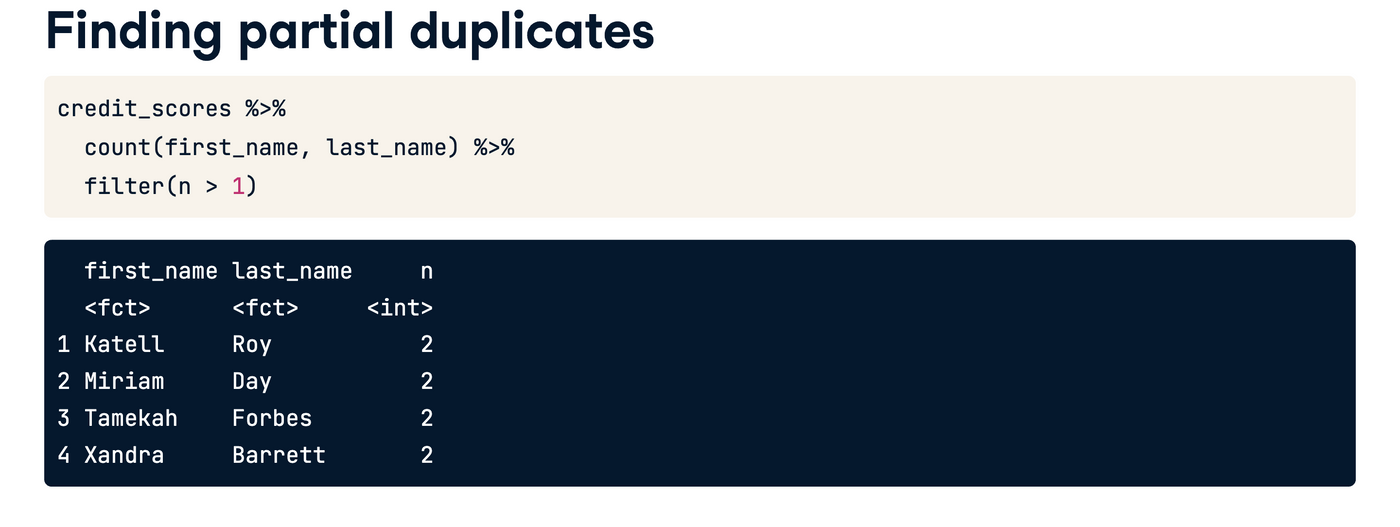

dropping partial duplicates 其实是有万金油的

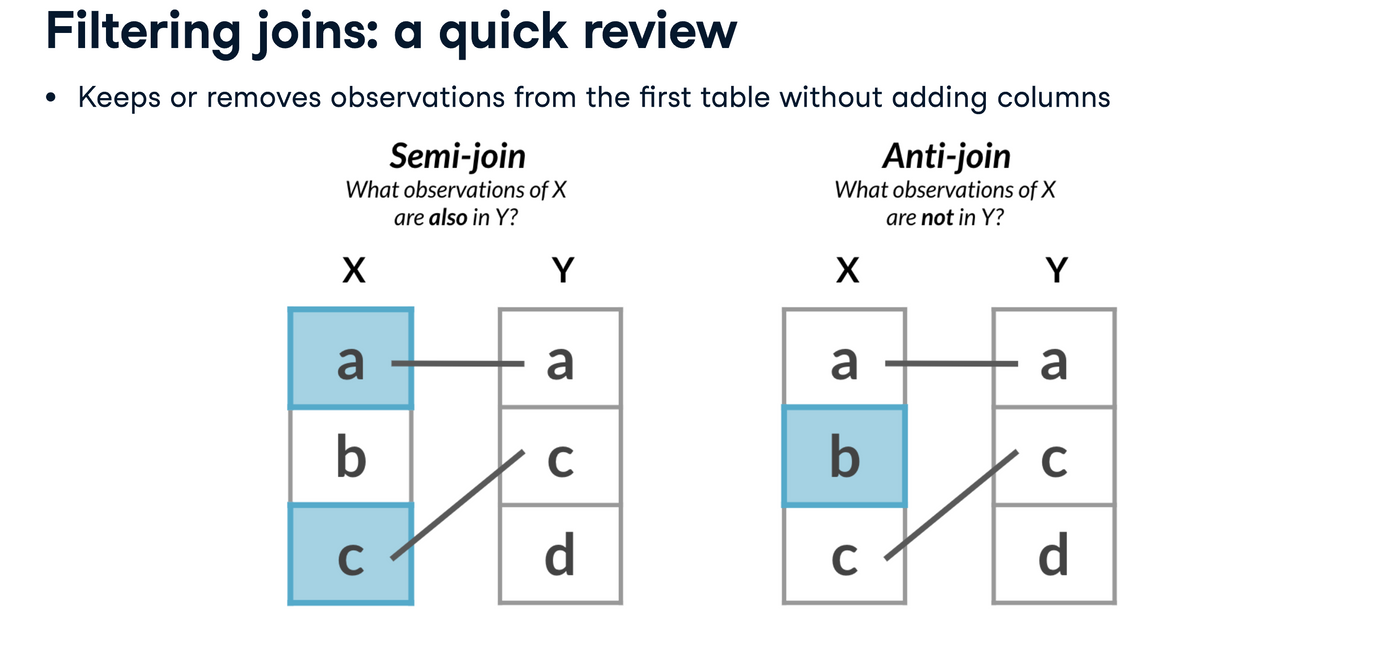

semi-join就是除怪,把怪踢出去

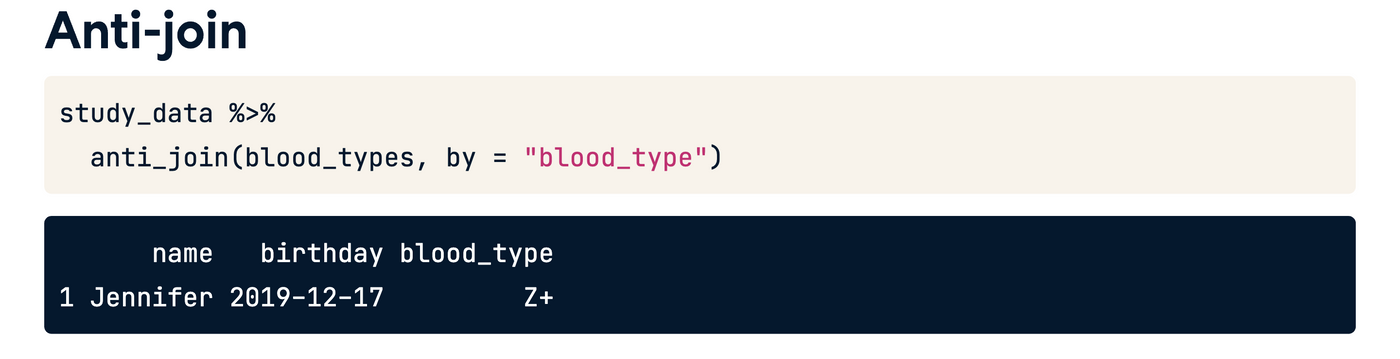

anti-join 是找怪,把怪单领出来

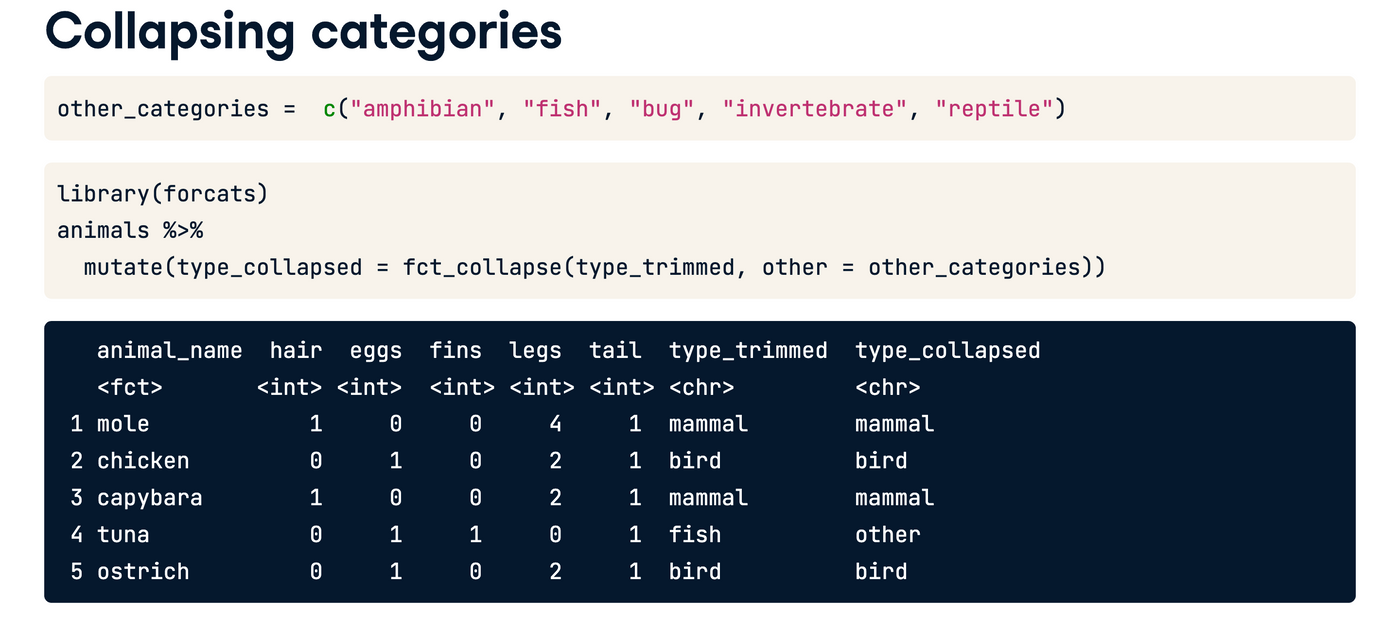

这个是和factor 有关的,data cleaning这门课说得很清楚。但是知识很杂,基本上每一章都可以另成一本书了

感觉到最后做project的时候会很管用,就是查level有没有啥奇奇怪怪不符合逻辑的归类

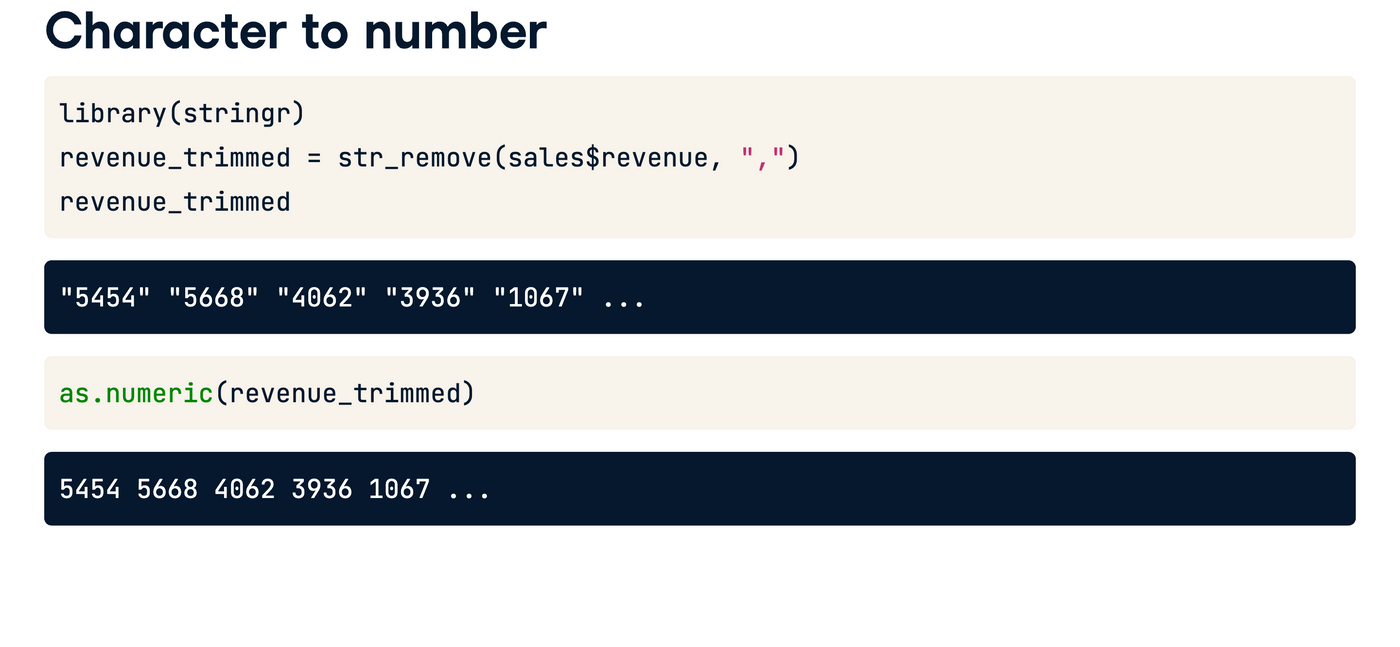

感觉stringr应该重新开一个文章。。。

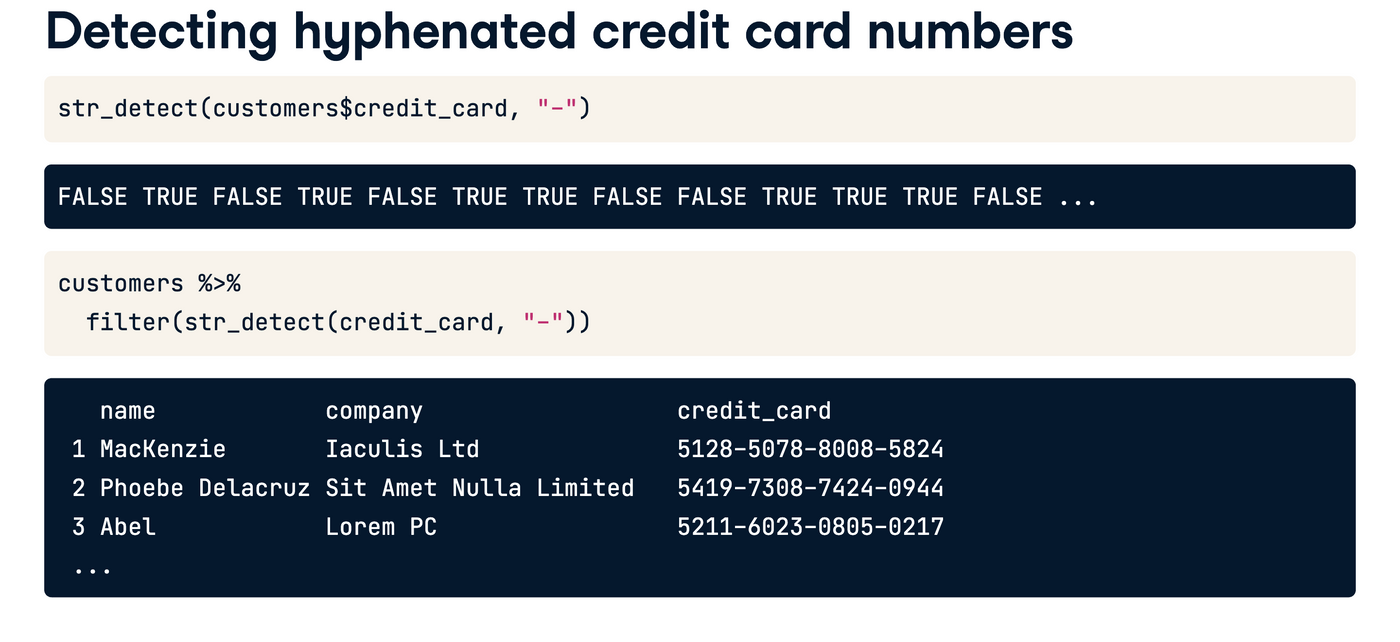

整个str家族都很牛逼,还能detect 哈哈哈

这个filter的用法也很神奇,啥也不写,就assume了logically TRUE

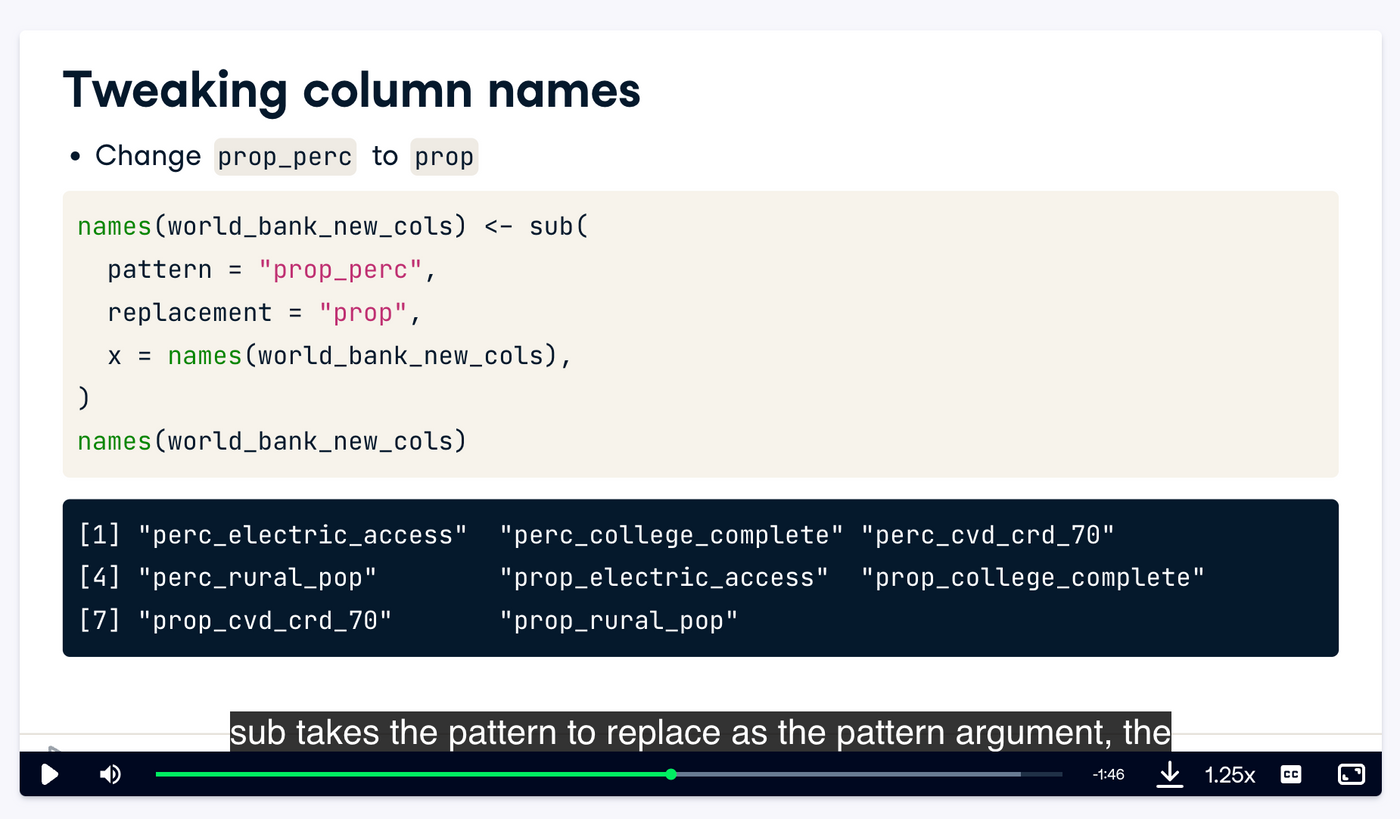

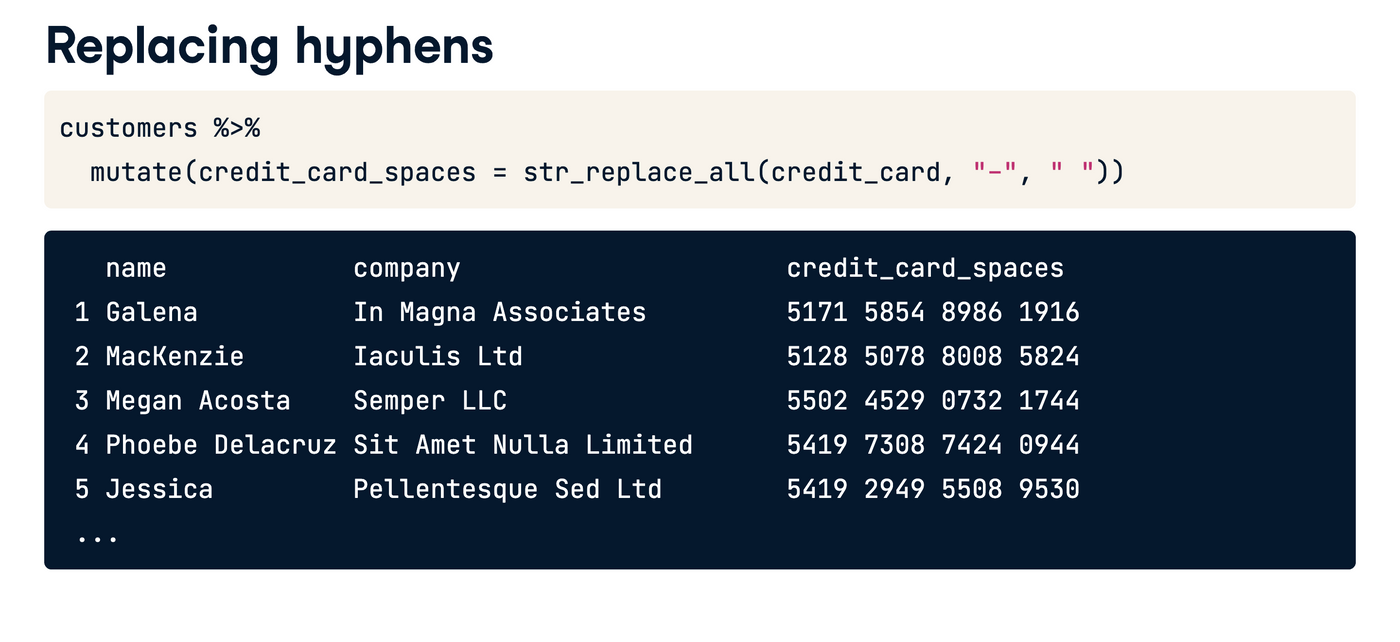

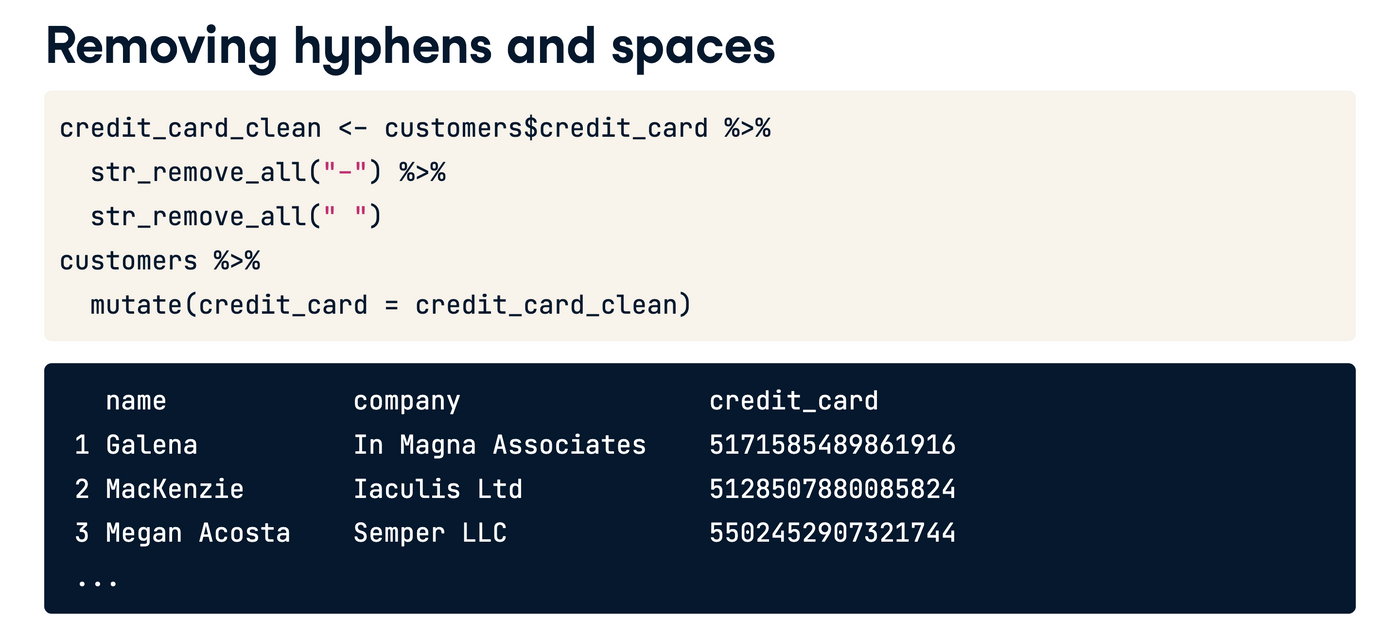

感觉如果不说_all的话,可能就只改第一个见到的

这个有点傻的知识点,只是想remind myself 一下

课programming with dpyr, 我觉得这个课教一些tidyverse dplyr 比较高阶的常识

真的,像什么across,还有前面带点的那些东西,要慢慢适应,不要怕

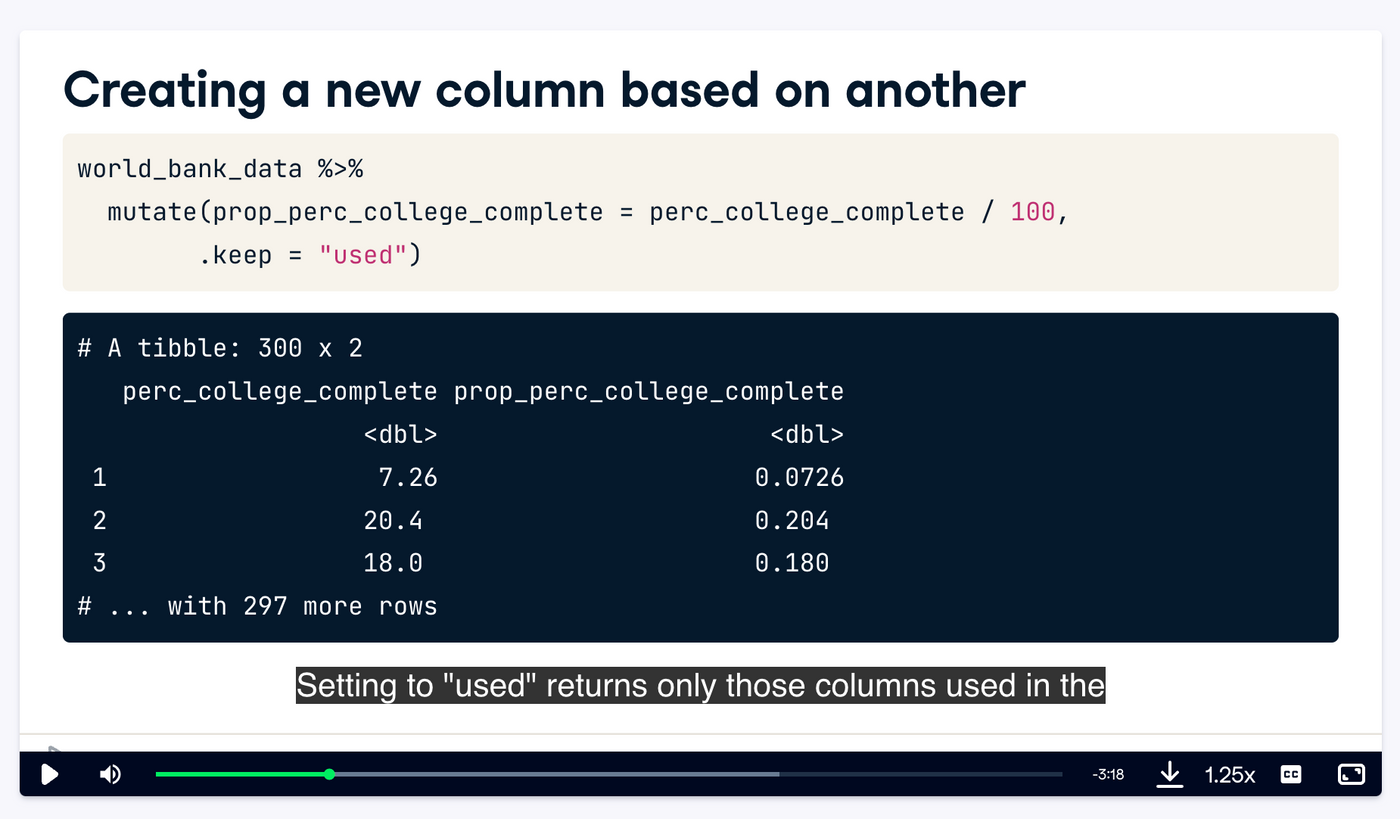

.keep = "used" 只会让那些用到过的columns 出现

.keep 的default 是全部

across 其实就是同时apply to multiple columns

感觉sub 是stringr里的,整个string manipulation 其实和NPL还有sentiment analysis是相关的。sentiment analysis 就是数褒义词和贬义词。