【思想】DeepSeek,ClosedAI 与技术家长主义

本文旨在提供一些关于 DeepSeek 这一近期热点话题的独特思考,简称蹭热度,包含部分暴论,各位读者且当一乐。考虑到读者知识背景的多样性,本文不会涉及过于专业的术语,力求所有读者都能理解。

本文不试图讨论 DeepSeek V3/R1 是否有创新性、是否有意识形态审查、是否涉及知识产权窃取、是否有地缘政治象征意义等话题,而是专注于揭露 DeepSeek 冲击事件中所展现的 OpenAI 们陷入的思维陷阱。如果说 DeepSeek 冲击是斯普特尼克时刻(Sputnik Moment),那么它并不必然通向登月成功,而更像是掀开了一面自我反思的镜子,只有愿意赤裸面对镜子的人才能开启新时代的阿波罗计划。

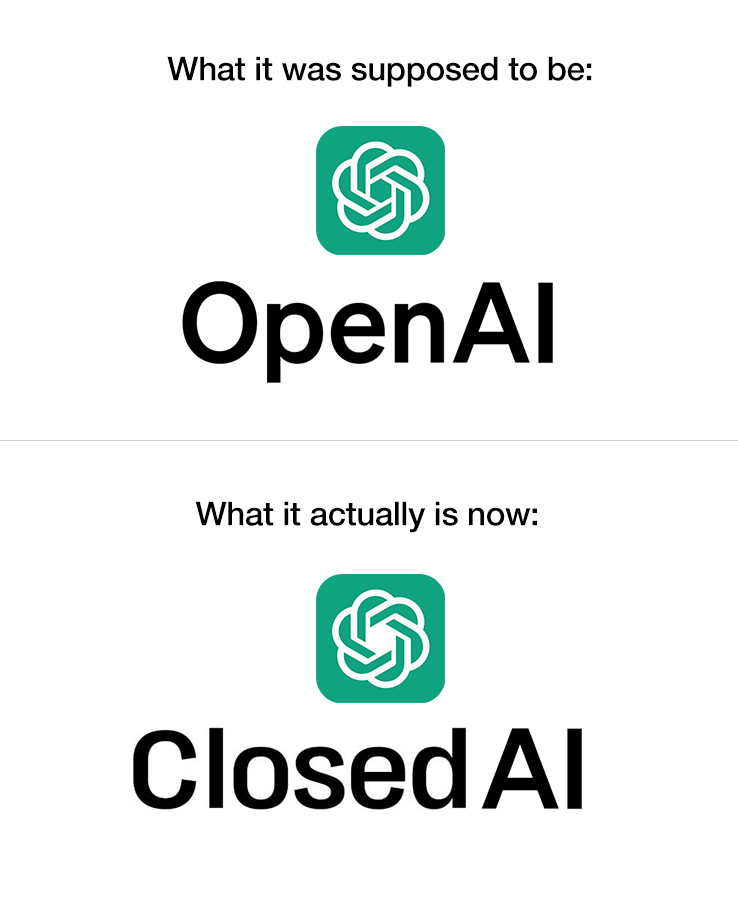

ClosedAI 的诞生

DeepSeek V3/R1 能引起如此热度,一方面是因为其优秀的性能(比肩 OpenAI o1),另一方面则是因为其开源(更准确地说是开放模型权重并提供详细技术报告,并非自由软件意义上的开源,本文不对其做深入区分)。某种程度上来说,这是天下苦 ClosedAI 们久矣的体现。

开源意味着全世界所有人不仅能在自己的设备上部署运行 DeepSeek V3/R1, 更能研读技术报告以学习其思路、设计、成果,从而应用在自己的研究或者产品之中,乃至在其基础上做出改进。然而讽刺的是,开源这一行为本不应如此瞩目,至少在以前是如此。计算机科学学术界早已浸润在自由软件运动(Free Software Movement)的氛围中,开源可以将研究成果以最快的速度被全世界的研究者们掌握,这种掌握也会转化为基于其上的改进和创新,同样会回馈到开源社区。可以说没有自由软件运动,就没有新世纪以来计算机科学研究的繁荣。

然而 2020 年问世的 GPT-3 首先打破了这一切,只提供了 API 让用户访问模型,OpenAI 也从此开始逐步变成了 ClosedAI。而 ChatGPT 诞生后,许多公司,如 Google、Anthropic、Perplexity,当然也包括 OpenAI,更是选择在技术报告中只展示测试结果,而对技术细节讳莫如深,目前巨头中只有 Meta 仍然坚持开放路线。

从 Open 走向 Closed, 这不是一小部分企业的选择,而代表着整个行业的转向。

技术家长主义

OpenAI 们为何逐步变成 ClosedAI,可以有很多解释。最简单的解释是为了商业利益,或者说叫“商业可持续性”,封闭模型可以确保竞争优势。或许这确实是 Sam Altman(OpenAI CEO)和 Dario Amodei(Anthropic CEO)们心里所想,但他们同时给出的另一个理由是担心模型滥用,例如生成虚假信息和恶意内容。

笔者无意指责这一理由是谎言,或许他们也确实在意大语言模型带来的道德挑战。但是,笔者认为这种对滥用的担心体现了、或者让 OpenAI 们陷入了技术家长主义(Technology Paternalism)的思维陷阱:认为用户缺乏足够的道德能力以“正确地”使用技术,而是像婴儿一样需要企业的教导。因此需要帮助用户做出选择,甚至替用户做出选择。用户无法识别危险内容,因而需要进行模型对齐(Alignment),乃至拒绝回答某些话题。一个常见的例子是,ChatGPT 认为用户可能无法合理地使用其生成的代码,以至于拒绝回答有关网络安全有关的一切问题,哪怕用户的目的是合理的。这种技术家长主义显然要通过对 AI 工具的封闭和垄断来达成。一旦模型是开源的,低成本的微调(Fine-tuning)就可以绕开许多模型对齐带来的限制。

或许 Sam Altman 们很享受这种当 AI 教父的感觉,但很显然我们不应该对此抱有过多的信任。技术家长主义的观点认为企业可以对“正确使用”做出公正裁决,但这可能是一种自我强化的逻辑——他们定义了何为正确,还通过控制访问方式来确保用户别无选择,只能接受他们的标准。在一个自由开放的社会中,不应该存在这样一种中心化的道德标准。

更进一步,技术家长主义也可能带来商业上的受益:OpenAI 们或许有意无意中推动了一种“AI 需要严格监管,否则社会将陷入混乱”的认知,以渲染恐慌,促使政府加快制定严格的 AI 监管措施。这种监管必然是有利于 OpenAI 们强化自身地位,同时提高后来者的准入门槛的。

道德的温室

一种广泛存在的观点认为这种技术家长主义体现了研究者们所需要承担的道德责任,即开发新技术的同时也要考虑技术的道德风险,因而 AI 研究者们有教导用户的责任。笔者认为这种观点大体上是正确的,但也有所片面。笔者并不认同技术中立主义,但技术的价值倾向性的另一面是人握有的道德准绳。如果人不具备独立价值判断,所有行为仅仅是顺着被设计成“善良”的工具们的指引,那他所握有的道德准绳有何意义?他作为一个独立的人的价值判断又体现在什么地方?

笔者将这种观点称之为“道德温室”——温室中的植物无法离开温室因而只能被人观赏。实际上,没有人是在从没接触过“有问题”信息的环境中长大的,这类信息就像促进人类免疫系统成熟的病原体一样,让我们的道德准绳更有力量。即使是虚假信息,我们对其的鉴别能力也需要通过接触虚假信息来锻炼。

在 AI 时代以前,精致的 PS 图片就已经可以做到以假乱真的地步(笔者认为如今 AI 生成图片绝大部分不如精致的 PS,还处于一眼假的程度),然而上网冲浪时间长的人,如今已经很少被这类图片所欺骗,事实核查(fact check)已成下意识行为。反倒是那些刚接触互联网没多久的人,很容易被这种图片欺骗(如移动互联网浪潮下首次接触网络的中老年人)。AI 造假是一种新时代的 PS,我们对其的抵御也需要通过接触它才能实现。

如果我们执拗地维持这个温室,那不止 AI,甚至网络自媒体也需要被审查——根据笔者观察,网络自媒体在事实准确度、分析深入程度、观点多样性等多个方面的平均水平远低于 AI。如果我们可以容忍自媒体,为什么不能部分容忍 AI 去打破温室呢?如果秉持技术家长主义的立场,言论审查似乎就不可避免了。

历史的进程

美国靠什么赢得了冷战,1000 个人有 1000 种答案。笔者的答案是开放的社会氛围所带来的整体社会繁荣——所有被容忍存在的种子中都可能孕育着改变未来的技术和思想。自由软件运动正是其中一种思想,这种思想也促进了整个社会维持开放。

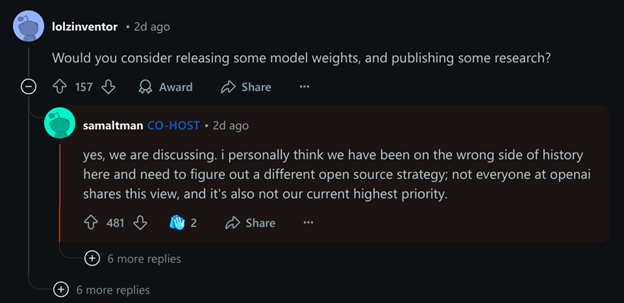

如今我们或许站在了一个历史的十字路口:是继续秉持技术家长主义,让 AI 技术走向封闭,还是选择过去的历史所指明的正确方向?就在笔者撰写本文的同时,Sam Altman 自己已经给出了答案:他自己站在了历史的错误一方。

或许我们应该回顾 2023 年 5 月的一篇旧文《We Have No Moat, And Neither Does OpenAI》(我们没有护城河,OpenAI 也没有),与开源社区为敌是注定失败的,封闭不会带来长久的技术护城河。DeepSeek 事件是这篇旧文的一次完美回应(callback)。

作者:FakeShinonome

Like my work? Don't forget to support and clap, let me know that you are with me on the road of creation. Keep this enthusiasm together!